HPE lance une architecture IA à l’échelle du rack basée sur le nouveau design Helios d’AMD, équipée d’une puce réseau ultrarapide Broadcom Tomahawk 6. La solution cible les fournisseurs cloud souhaitant déployer l’entraînement et l’inférence IA à grande échelle.

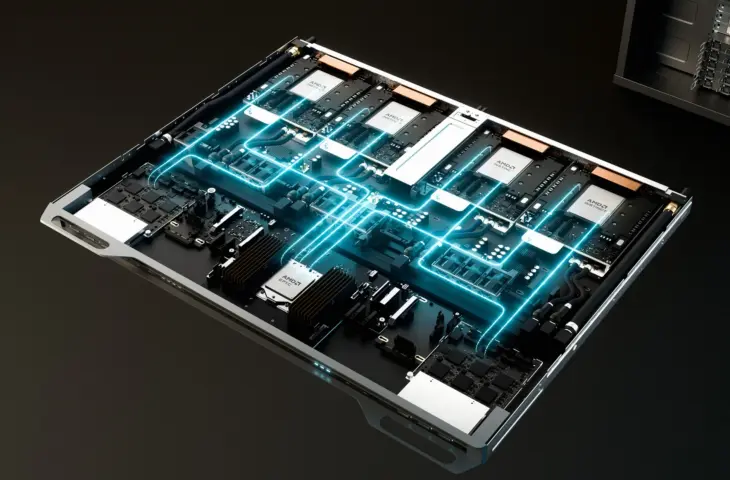

HPE commercialise une nouvelle architecture IA à l’échelle du rack qui combine la plateforme Helios d’AMD avec un commutateur Ethernet développé par HPE Juniper Networking. La solution offre aux fournisseurs de services cloud un rack entièrement intégré conçu pour des charges de travail telles que l’entraînement de modèles avec des billions de paramètres et l’inférence à grande échelle.

IA à l’échelle du rack pour répondre à la demande croissante en puissance de calcul

Juste avant HPE Discover Barcelona 2025, la marque annonce un rack offrant une bande passante scale-up de 260 To/s et une puissance de calcul FP4 de 2,9 exaflops grâce à 72 GPU AMD Instinct MI455X couplés. HPE cible ainsi les organisations souhaitant étendre leurs clusters IA tout en conservant flexibilité et standards ouverts. Les configurations peuvent atteindre 31 To de mémoire HBM4 et 1,4 Po/s de bande passante mémoire.

L’architecture du rack suit les spécifications Open Rack Wide de l’Open Compute Project (OCP). Cette norme introduit une construction de rack double largeur avec refroidissement liquide et une disposition facilitant la maintenance. L’accent mis sur les standards ouverts s’aligne avec la stratégie précédemment démontrée par HPE d’éviter le verrouillage fournisseur.

Ethernet comme réseau scale-up pour l’entraînement IA

Un élément notable de la solution est l’utilisation d’Ethernet pour le trafic réseau scale-up au sein du rack. La nouvelle plateforme de commutation, développée avec le silicon Tomahawk-6 de Broadcom, utilise Ultra Accelerator Link over Ethernet (UALoE).

En déployant Ethernet comme couche de connexion, HPE souhaite offrir une alternative aux technologies d’interconnexion propriétaires. Cela s’inscrit dans la stratégie réseau IA plus large de HPE, où les couches réseau scale-up, scale-out et scale-across se complètent au sein des centres de données IA.

La nouvelle plateforme de commutation s’intègre aux composants réseau HPE existants tels que le commutateur scale-out QFX5250 et les routeurs PTX, comme éléments de base pour les connexions de clusters IA au sein et entre les centres de données.

lire aussi

HPE étend ses supercalculateurs Cray avec de nouveaux composants

Intégration du refroidissement liquide et des services HPE

Le système est livré avec le support des équipes de service HPE, qui ont l’expérience des infrastructures refroidies par liquide et des installations exascale. HPE souligne à plusieurs reprises que le refroidissement liquide est essentiel pour les nouvelles générations d’IA, notamment pour le commutateur QFX5250 et le rack Helios lui-même. Le refroidissement intégré doit limiter la consommation d’énergie et permettre aux clusters GPU densément peuplés de fonctionner de manière stable.

Le rack prend également en charge le logiciel ROCm d’AMD et la technologie Pensando pour l’accélération réseau et la sécurité. Avec cette combinaison, HPE souhaite offrir aux entreprises une architecture ouverte adaptée à l’itération rapide des modèles IA et aux scénarios de déploiement à grande échelle.

Le rack IA AMD Helios sera disponible mondialement en 2026.