Il sera bientôt possible de vérifier dans Google Search si une image a été générée par l’IA ou non. Google utilise pour cela l’authentification C2PA.

Google prévoit de publier une technologie pour identifier si une photo a été prise avec un appareil photo, éditée avec un logiciel ou générée par l’IA. Cette technologie sera déployée sous la forme d’une fonction « à propos de cette image », qui apparaîtra dans les résultats de recherche. Google utilise un système qui fait partie de la « Coalition for Content Provenance and Authenticity » (C2PA). L’outil apparaîtra dans Google Search et Google Ads dans les mois à venir, bien qu’il faut une meilleure interopérabilité avec d’autres pour en tirer tout le potentiel.

La norme C2PA

Le système de Google fait partie de la « Coalition for Content Provenance and Authenticity » (C2PA). La C2PA définit des normes techniques pour la provenance des contenus numériques, en collaboration avec d’autres grandes entreprises technologiques. En plus de Google, Amazon, OpenAI, Intel, Microsoft et Adobe soutiennent également l’authentification C2PA. Google a joué un rôle dans l’élaboration de la dernière norme technique C2PA (version 2.1).

Si une image contient des métadonnées C2PA, les utilisateurs peuvent utiliser la fonction « À propos de cette image » pour savoir si elle a été créée à l’aide d’outils d’IA. Les utilisateurs disposent ainsi d’un contexte plus large sur l’image. Google lancera cette dernière version de Content Credentials dans Google Search et Google Ads dans les mois à venir. L’outil sera disponible dans Google Images, Lens et Circle to Search.

L’interopérabilité

Même si Google a adopté la norme d’authentification de la C2PA, elle n’a aucune chance de réussir tant qu’elle n’est pas largement adoptée. Seuls quelques appareils photo prennent en charge la norme technique ouverte de la C2PA, qui ajoute des métadonnées à l’image. Pour réussir vraiment, il faut donc que l’interopérabilité avec l’ensemble du matériel et des logiciels soit au point.

Microsoft lance la fonctionnalité Copilot Pages, un nouveau tableau IA au sein de Business Chat où les données de travail et les données web sont réunies, et où les collègues peuvent partager et éditer du contenu généré par l’IA.

Microsoft lance Copilot Pages, un nouveau tableau d’intelligence artificielle qui, au sein de Business Chat, sert de point de collaboration pour les données web et professionnelles. Dans ce nouveau modèle d’IA, les collègues peuvent collaborer sur du contenu généré par l’IA, en le partageant et en le modifiant en temps réel. Microsoft veut devenir la nouvelle interface utilisateur pour l’IA avec Copilot. Copilot Pages est déployé dès maintenant pour les clients de Microsoft 365 Copilot, et sera accessible à tous dans le courant du mois.

Copilot Pages

Business Chat est un outil centralisé qui rassemble toutes les données de votre entreprise, telles que les données web et les données de travail. Dans Business Chat, les utilisateurs peuvent collaborer avec Copilot comme un véritable partenaire. Microsoft y ajoute une nouvelle fonctionnalité, Copilot Pages, pour améliorer l’expérience de Business Chat. Copilot Pages est un canevas conçu pour stimuler la collaboration en permettant aux utilisateurs de partager et de modifier entre eux du contenu généré par l’IA. On peut donc collaborer avec son équipe sur une page avec Copilot et suivre le travail ou les ajouts de ses collègues en temps réel.

Pages est déployé dès maintenant pour les clients de Microsoft 365 Copilot et sera disponible de manière générale dans le courant du mois. De plus, Microsoft proposera également Copilot Pages aux plus de 400 millions de personnes qui ont accès au chatbot gratuit Copilot de l’entreprise quand elles sont connectées avec un compte d’entreprise Microsoft Entra.

Le nouveau record de distance Wi-Fi utilise la norme HaLow et atteint une vitesse maximale de 2 Mbps sur une distance de 15,9 kilomètres.

La distance, la puissance et la consommation d’énergie. Pour chacun de ces trois facteurs, la norme Wi-Fi HaLow (802.11ah) obtient d’excellents résultats. Au début de l’année, Morse Micro, une entreprise de technologie sans fil, a montré qu’elle pouvait couvrir une distance de trois kilomètres. Aujourd’hui, elle a battu ce record et enregistre un nouveau record mondial de 15,9 kilomètres.

Dans le premier test au début de l’année sur une distance de trois kilomètres, Morse Micro a atteint des vitesses de 11 Mbps à 500 mètres et de 1 Mbps à 3 kilomètres. Aujourd’hui, elle enregistre une vitesse de pointe impressionnante de 2 Mbps à 15,9 kilomètres.

Morse Micro a ainsi atteint la portée maximale théorique de sa technologie Wi-Fi HaLow. Elle mûrit ainsi peu à peu et devient la solution idéale pour les grands espaces extérieurs à faible portée. C’est également l’objectif de la technologie HaLow ; elle ne sert à rien dans les environnements urbains surpeuplés ou même dans les villages. Il faut plutôt penser aux grands sites industriels ou aux organisations agricoles en tandem avec des capteurs IoT et d’autres applications P2P.

15,9 kilomètres, c’est un record mondial imposant en termes de portée Wi-Fi. Le maximum de distance semble déjà atteint, mais peut-être que Morse Micro peut encore augmenter la vitesse. La norme Wi-Fi HaLow ne fait pas recette aujourd’hui, mais peut-être que des résultats comme celui-ci pourraient faire avancer les choses au fil du temps ?

lire aussi

Wi-Fi 6 et Wi-Fi 6E : meilleur que le 802.11 ?

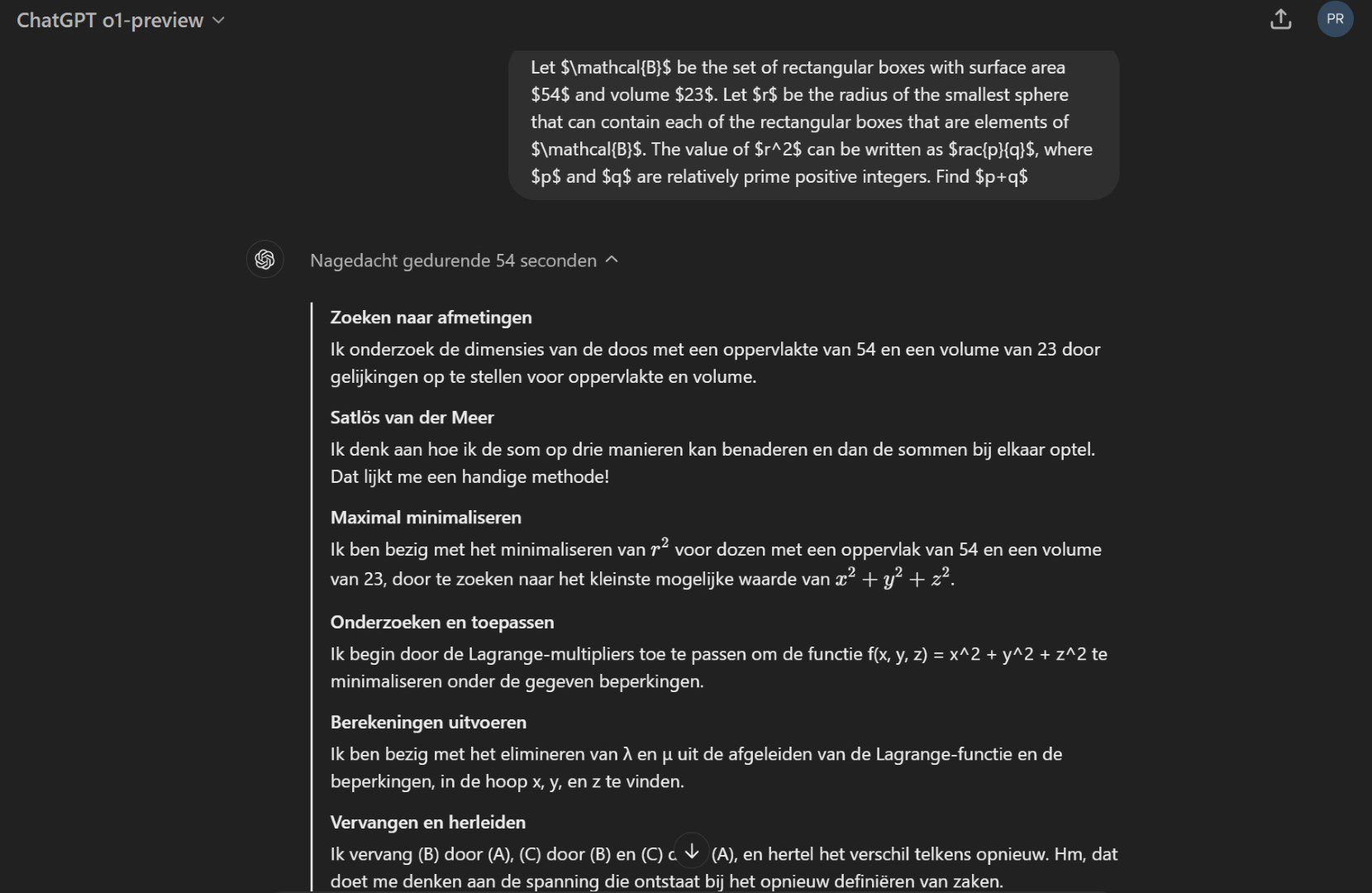

Le mystérieux projet « Strawberry » de l’OpenAI révèle ses secrets. OpenAI o1 est le dernier modèle d’IA qui excelle dans les tâches de raisonnement.

Ces derniers jours, de nombreuses rumeurs ont circulé sur le « projet secret » d’OpenAI appelé Strawberry. L’entreprise lance aujourd’hui le nouveau modèle qui se cache derrière ce projet : OpenAI o1. Ce modèle répondrait plus lentement que, par exemple, ChatGPT-4o. En effet, le modèle réfléchit d’abord et passe par un processus de raisonnement complet avant de fournir une réponse. Il est donc adapté à la résolution de tâches mathématiques complexes. OpenAI o1 apparaît en préversion pour les utilisateurs de ChatGPT-Plus.

« Réfléchit avant de répondre »

Le nouveau modèle o1 d’OpenAI réfléchit avant de répondre. C’est ainsi qu’OpenAI présente son nouveau membre. Le modèle répondra donc beaucoup plus lentement que le ChatGPT-4o, mais OpenAI explique cela par le fait que le chatbot vérifiera mieux si ce qu’il dit est vrai.

OpenAI utilise ce que l’on appelle la chaîne de pensée, qui est intégrée au modèle. Le modèle se distingue principalement dans les tâches de raisonnement. Parce qu’il écrit d’abord une longue « chaîne de pensée » avant que la réponse ne vienne, le modèle peut proposer plusieurs réponses et donc faire moins d’erreurs. Cela devrait également conduire à moins d’hallucinations.

Dans l’image ci-dessus, on peut voir un exemple du processus de raisonnement de o1. Lorsqu’une question mathématique complexe lui est posée, le modèle prend son temps pour donner une réponse. Cela est d’ailleurs indiqué : le modèle a mis 54 secondes pour le faire. De plus, pendant ce temps, vous pouvez voir à quelle étape du processus de raisonnement le modèle se trouve. Le résultat est un raisonnement étendu qui montre comment le modèle est parvenu à la réponse.

Talent de raisonnement

Le point fort d’OpenAI o1 réside dans ses tâches de raisonnement. Les problèmes complexes peuvent être résolus de manière très efficace. En effet, le test de référence MATH montre qu’o1 obtient un score de 94,8 %. C’est une grande différence par rapport au score de GPT-4o, qui est de 60,3 %. Alors, pour quelles tâches le modèle n’est-il pas adapté ? Le téléchargement de fichiers ou la génération d’images, pour lesquels le GPT-4o est toujours aussi performant. La préversion o1 est disponible dès maintenant, mais uniquement pour les utilisateurs de ChatGPT-Plus.

La startup française d’IA Mistral a développé son premier modèle d’IA multimodale. Pixtral 12B est basé sur NeMo 12B et comprend 12 milliards de paramètres.

Mistral AI lance son premier modèle d’IA capable de traiter à la fois des images et du texte. Pixtral 12B est le nouveau et premier modèle multimodal de Mistral AI, basé sur l’un des modèles de texte de Mistral AI, NeMo 12B. L’entreprise a seulement publié un lien via Hugging Face où les développeurs peuvent télécharger Pixtral 12B. Aucune information sur les détails techniques et les conditions exactes de licence n’a encore été communiquée.

Modèle multimodal

En juillet, l’entreprise a annoncé son plus grand modèle d’IA à ce jour, Large 2, qui est un concurrent des autres LLM existants. Ce qui manque à ce modèle, c’est l’aspect multimodal. Mistral AI essaie maintenant d’offrir cet aspect avec le nouveau Pixtral 12B. Ce modèle est basé sur le NeMo 12B de Mistral, a une taille d’environ 24 Go et contient 12 milliards de paramètres.

Pixtral 12B peut répondre à des questions sur un nombre arbitraire d’images de taille arbitraire et sur des URL d’images données ou des images encodées avec base64, le système d’encodage binaire en texte. Les données d’images utilisées par Mistral pour développer Pixtral 12B ne sont pas encore claires.

Disponibilité

Le modèle est disponible sur Hugging Face où il peut être téléchargé, affiné et utilisé sous la licence standard de Mistral. Une licence payante serait nécessaire pour les applications commerciales, à l’exception de la recherche et de l’enseignement. L’entreprise n’a pas encore communiqué sur les détails techniques et les conditions exactes de la licence.

Mistral AI est une entreprise récente qui a déjà développé une série de modèles d’IA, profitant de sa place dans le paysage de l’IA. Par exemple, l’entreprise d’IA a lancé NeMo en collaboration avec Nvidia, peu de temps après le modèle d’IA Large 2 a vu le jour. De plus, Mistral s’adresse également aux développeurs, avec le lancement de Codestral : son modèle d’IA pour le codage.

Adobe présente les premières images de son nouvel outil vidéo Firefly AI, qui permet de générer des clips AI à partir de textes, d’images et de vidéos existantes.

Adobe montre une préversion de son nouvel outil d’IA vidéo qui sera disponible en version bêta dans le courant de l’année. Ces outils de génération de vidéos IA peuvent automatiser une grande partie du travail créatif et créer des clips IA à partir de textes, d’images et de vidéos existantes. Il sera disponible en version bêta au cours de l’année. Il y a une liste d’attente pour les intéressés.

Outils vidéo d’IA

Adobe Firefly a vu le jour en mars 2023, avec de nombreuses nouvelles applications en l’espace d’un an. Aujourd’hui, Adobe lance les outils de génération de vidéos IA Firefly. Ces outils d’IA vidéo annoncés sont à la fois remarquables et inquiétants. Adobe donne un aperçu des fonctionnalités de l’outil Firefly AI. Par exemple, il peut créer des vidéos d’IA à partir de textes, d’images fixes et de vidéos existantes. Le vidéo ci-dessous montre la simplicité et la fascination de l’outil d’Adobe.

Les vidéastes peuvent par exemple se servir de l’outil d’IA pour supprimer les objets indésirables d’une scène, rendre les transitions fluides, combler les lacunes et trouver la bobine B parfaite. Il inclut aussi des outils permettant de contrôler l’angle, le mouvement et le zoom de la caméra dans les vidéos. Selon l’entreprise, les vidéastes seront ainsi plus libres de trouver de nouvelles idées créatives.

Version bêta

Adobe affirme que le modèle vidéo Firefly est conçu pour être commercialement sûr et n’est formé qu’à partir de contenus que l’entreprise a le droit d’utiliser. Les outils de génération de vidéos IA Adobe Firefly seront disponibles en version bêta dans le courant de l’année. Les personnes intéressées par cette version peuvent s’inscrire à l’avance sur la liste d’attente.

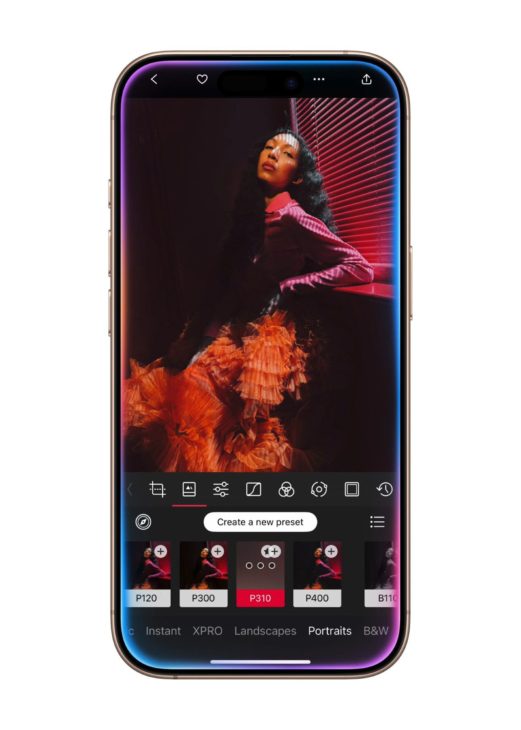

Avec son iPhone 16 Pro, Apple vise les utilisateurs créatifs et propose de nombreuses nouvelles fonctionnalités photographiques haut de gamme. Le prix ne change pas et commence à partir de 1 229 euros.

Simultanément au lancement de l’iPhone 16, Apple met également à jour la variante Pro cette année. La principale innovation extérieure est sans aucun doute la taille plus grande de l’appareil. L’écran de l’iPhone 16 Pro passe de 6,1 à 6,3 pouces. Fait intéressant, l’iPhone 16 Pro Max, plus grand, passe lui aussi de 6,7 à 6,9 pouces. Apple affirme que les bords de l’écran sont plus fins que jamais, mais cela n’enlève rien au fait que la taille des appareils augmente.

De nouveau, le châssis est en titane pour réduire le poids. Le bouton d’action qui a fait ses débuts l’année dernière est complété par un bouton tactile sur le côté droit. Grâce au retour haptique, on peut contrôler l’appareil photo pour prendre rapidement une photo ou une vidéo. En appuyant plus longuement sur le bouton, on fait défiler les fonctions par balayage. Le zoom s’effectue par balayage sans tapoter. Les développeurs d’applications auront accès au bouton pour inventer leurs propres interactions.

Puce A18 Pro pour l’IA

Nouvelle année, nouvelle puce pour le modèle Pro de la gamme iPhone. Au niveau des performances, Apple parle d’un gain limité. Le processeur offre jusqu’à 15 % de performances supplémentaires, le GPU jusqu’à 20 % sur l’iPhone 16 Pro.

Le téléphone se concentre principalement sur les performances de l’IA, et plus particulièrement sur l’Apple Intelligence. Par exemple, il est possible d’utiliser Apple Visual Intelligence en montrant quelque chose à l’iPhone à l’aide de l’appareil photo. Les 16 cœurs neuronaux de la puce A18 Pro devraient traiter cette information en un clin d’œil. Pour l’instant, cette fonction, comme toutes les autres fonctions d’intelligence artificielle, n’est pas encore disponible en Europe. C’est un moyen pour Apple de protester contre les règles de la loi sur les marchés numériques (« Digital Markets Act », DMA). Apple est considéré comme un contrôleur d’accès et doit se conformer à des réglementations strictes.

Accent mis sur les professionnels créateurs

Les trois appareils photo au dos sont presque identiques à ceux de l’iPhone 15 Pro Max de l’année dernière. Il y a un appareil photo principal de 48 mégapixels, un appareil photo grand angle actualisé de 48 mégapixels et un appareil photo à zoom optique 5x de 12 mégapixels. Pour la première fois, le « petit » modèle Pro bénéficie de ce zoom optique amélioré. Les appareils photo des deux tailles d’écran sont désormais identiques.

Les principales nouveautés sont l’enregistrement vidéo en 4K 120 images/seconde et quatre microphones qui offrent une « qualité studio », selon Apple. L’iPhone 16 Pro vous permet également d’enregistrer des mémos vocaux avec une piste sonore qui peut être superposée. Enfin, de nouveaux styles de photos peuvent être appliqués après avoir pris la photo.

Une batterie bien plus performante

Selon Apple, les deux modèles iPhone 16 Pro ont une bien meilleure autonomie. C’est probablement grâce à la taille un peu plus grande de l’appareil, due à des écrans plus grands. La variante Pro Max pourrait atteindre 33 heures de lecture vidéo. La variante Pro plus petite atteint 27 heures.

Grâce à MagSafe (charge sans fil Qi2), la charge rapide est désormais possible jusqu’à 25 watts. Les deux téléphones sont à nouveau résistants à l’eau selon la norme IP68 et prennent désormais en charge le Wi-Fi 7. Le transfert de données via la connexion USB-C se fait à la vitesse de l’USB 3.1.

Prix et disponibilité

On peut commander les deux nouveaux modèles Pro à partir du 13 septembre. Ils seront livrés à partir du 20 septembre. Les prix sont identiques aux deux modèles précédents. L’iPhone 16 Pro (6,3 pouces) est disponible à partir de 1 229 euros en quatre teintes de titane avec 128 Go de stockage. Le modèle supérieur avec 1 To de stockage est disponible à partir de 1 859 euros.

L’iPhone 16 Pro Max (6,9 pouces) est proposé à partir de 1 479 euros avec un espace de stockage de 256 Go. La variante la plus chère avec 1 To de stockage coûte 1 979 euros.

Tous les prix indiqués ci-dessus sont TTC.

Qualcomm lance deux variantes plus légères de ses processeurs Snapdragon X Plus, destinées aux ordinateurs portables plus abordables. Une puce pour ordinateur de bureau est également prévue.

Le développeur de puces Qualcomm élargit sa gamme de processeurs pour ordinateurs portables avec la X1P-46-100 et la X1P-42-100. Ces deux puces portent la marque Snapdragon X Plus et disposent de huit cœurs de traitement au lieu des 10 habituels. La mémoire cache de ces nouveaux processeurs est également plus petite, avec 30 Mo contre 42 Mo pour toutes les puces précédemment commercialisées.

Les deux nouveaux processeurs sont baptisés Snapdragon X Plus 8-core, un nom bien choisi. Les cœurs de calcul sont cadencés à 3,4 GHz et 3,2 GHz respectivement, avec un boost turbo à 4 GHz et 3,4 GHz.

GPU et NPU

Le GPU embarqué est également moins puissant et n’est destiné qu’à optimiser les écrans pour le travail de bureau. Le NPU n’a pas changé par rapport aux modèles supérieurs. Cette décision est nécessaire pour rester compatible avec les puces Copilot+ de Microsoft, bien que l’impact sur les performances de l’utilisateur ne soit pas vraiment perceptible.

Selon Qualcomm, ces deux nouveaux processeurs sont parfaits pour les ordinateurs portables d’entrée de gamme, dont le prix est inférieur à 1 000 euros. Dans cette catégorie de prix, Qualcomm peut avoir une forte influence grâce à ses puces ARM économiques mais puissantes.

Ordinateur de bureau

En temps voulu, Qualcomm souhaite également faire son entrée dans le monde des ordinateurs de bureau. Selon PCWorld, des puces destinées aux ordinateurs de bureau classiques, aux mini-ordinateurs de bureau et, à terme, aux stations de travail de bureau seraient en préparation. Qualcomm n’a pas encore communiqué de calendrier concret pour leur lancement.

Intel présente deux nouvelles familles de processeurs : Intel Xeon W-3500 et Xeon W-2500. Toutes deux sont destinées aux stations de travail.

Intel présente deux nouvelles familles de processeurs conçus pour les stations de travail. La famille Intel Xeon W-3500 contient les puces les plus avancées, tandis que la famille Xeon W-2500 est conçue pour les stations de travail plus courantes.

Nœud plus ancien

Les puces sont construites sur l’architecture Sapphire Rapids et fabriquées par Intel elle-même sur le processus de cuisson Intel 7. Elles n’utilisent donc pas la technologie ultramoderne, mais l’ancien nœud de 10 nm qui existe depuis de nombreuses années.

La puce la plus puissante de la gamme est la Xeon w9-3595X. Ce processeur possède 60 cœurs de calcul, tous équipés d’une fréquence d’horloge de base de 2 GHz et d’une capacité turbo jusqu’à 4,8 GHz. Pour la Xeon-W, Intel garde à l’esprit les performances, donc toutes les puces sont exclusivement équipées de puissants cœurs P qui prennent en charge le « multithreading ».

La série Xeon W-2500 comprend des puces d’entrée de gamme telles que l’Intel Xeon w3-2535, qui est équipée de dix cœurs de traitement et a une fréquence d’horloge de base de 3,5 GHz.

Caractéristiques

Voici quelques spécifications additionnelles qui montrent que l’accent est mis sur la performance :

- Fréquence d’horloge jusqu’à 4,8 GHz

- Jusqu’à 112,5 Mo de cache L3

- 8 canaux de mémoire DDR5-4800

- Jusqu’à 4 To de RAM

- Jusqu’à 112 voies PCIe 5.0

Il est intéressant de constater que pour ces puces professionnelles, Intel a largement abandonné son slogan marketing sur l’IA. Pour ces processeurs, aucun NPU occupe inutilement de l’espace.

Les nouvelles puces sont disponibles immédiatement et seront intégrées dans le matériel des fabricants de PC. HP, Dell et Lenovo présenteront leurs premiers systèmes le mois prochain. Les prix varient entre 609 dollars (pour le Xeon w3-2525 d’entrée de gamme) et 5 889 dollars (pour le Xeon w9-3595 haut de gamme).

Xeon-W vs Threadripper Pro

Intel est en concurrence avec AMD avec ses processeurs Xeon-W, et plus particulièrement avec l’offre AMD Threadripper Pro plus puissante de l’année dernière. AMD propose des puces plus puissantes, comme le Threadripper Pro 7995WX avec ses 96 cœurs, sa fréquence d’horloge de base plus élevée de 2,5 GHz et sa fréquence de boost plus élevée de 5,1 GHz. Intel ne peut rivaliser avec aucune des puces de sa nouvelle offre.

Le concurrent le mieux placé en haut du spectre est l’AMD Ryzen Threadripper PRO 7985WX avec ses 64 cœurs, opposé à l’Intel Xeon w9-3595. Le processeur d’AMD a quelques cœurs supplémentaires, une fréquence d’horloge nettement plus élevée (3,2 GHz et 5,1 GHz turbo), et il est fabriqué sur le nœud TSMC 5nm plus moderne.

Sur le plan performance, Intel n’a rien pour gagner, mais l’entreprise a tiré les leçons de ces dernières années. Si l’on compare le prix de vente conseillé des deux puces en dollars au moment du lancement, le processeur d’Intel est nettement moins cher : 5 889 dollars contre 7 349 dollars pour AMD.

X est en train de développer sa propre plateforme de vidéoconférence. C’est pour un usage interne ou va-t-elle rivaliser avec Zoom et Microsoft Teams ?

L’employé Chris Park dévoile un premier secret sur X Conference sur la plateforme de médias sociaux anciennement connue sous le nom de Twitter. X teste une toute nouvelle plateforme de vidéoconférence pour des réunions internes. Le PDG Elon Musk le confirme également avec un emoji flamme approbateur.

X Conference semble plutôt simple à en juger par les premières captures d’écran, mais Park ose déjà le décrire comme « une très bonne alternative » à Zoom et à Microsoft Teams. De nombreuses fonctionnalités sont encore prévues pour être à la hauteur de cette déclaration, comme les notifications améliorées, la possibilité d’épingler des participants, les sous-titres et l’audio spatial.

En concurrence avec Zoom et Microsoft

Il est encore trop tôt pour savoir exactement comment X compte utiliser la plateforme de réunion. L’entreprise ne communique pas encore sur un éventuel lancement. L’outil est-il destiné à un usage interne ou va-t-il se lancer à corps perdu dans le marché de la vidéoconférence ?

Avec Elon Musk, on ne sait jamais quel est son plan : il a déclaré à plusieurs reprises qu’il voulait faire de X une « application totale ». La communication en direct n’est pas un terrain inconnu pour l’entreprise. Avec Spaces, on peut déjà passer des appels audio aujourd’hui. La vidéo n’est donc qu’une petite étape de plus.

Reste à savoir si la demande pour un nouveau logiciel de vidéoconférence sera très forte. Avec Zoom, Teams et Google Meet, les noms connus sont bien établis, WhatsApp s’impose de plus en plus, et au-delà, il y a des plateformes moins connues dans nos régions comme AWS Chime et Cisco Webex. La plupart des entreprises ont fait leur choix pendant la période Covid-19 et il ne semble pas réaliste qu’un nouvel nom puisse convaincre les utilisateurs de changer de plateforme.

Bientôt, tout le monde pourra utiliser gratuitement le générateur IA Midjourney. Mais, une fois que la limite de 25 images gratuites sera atteinte, il faudra passer à un abonnement payant.

David Holz, PDG de Midjourney, a annoncé via Discord que le générateur d’images IA Midjourney sera bientôt gratuit pour tous. Dès lors, les utilisateurs pourront s’inscrire sur le site web pour créer des images générées par l’IA sans payer, bien qu’il y ait une limite. Les utilisateurs gratuits recevront jusqu’à 25 images gratuites, après quoi il faudra passer à un abonnement payant pour continuer à utiliser l’outil web. Il existe quatre formules d’abonnement différentes : Basic, Standard, Pro et Mega.

Générateur IA

En 2022, Midjourney a été intégré à Discord sous la forme d’un bot, mais il a rapidement évolué un an plus tard pour devenir un site web où les utilisateurs peuvent générer des images sur la base d’un message écrit. Ce site était auparavant accessible aux utilisateurs ayant généré plus de dix mille images sur Discord.

Grâce aux changements annoncés, tout le monde pourra utiliser Midjourney via le site web. Pour ce faire, il faut simplement se connecter à l’aide d’un compte Discord ou Google. Cependant, son utilisation est limitée : par exemple, on ne peut générer que 25 images. Une fois cette limite atteinte, il faut passer à un abonnement payant pour pouvoir continuer à utiliser Midjourney.

Si vous souhaitez souscrire à un abonnement payant, quatre formules d’abonnement vous sont proposées : Basic, Standard, Pro et Mega. Ces abonnements ont différents critères et prix, dont vous trouverez un aperçu ici.

xMEMS Labs présente un ventilateur de 1 mm qui peut être placé sur la puce d’un appareil électronique. Cela permet un refroidissement actif plus efficace dans les appareils électroniques minces, tels que les smartphones et les tablettes.

La surchauffe peut être fatale aux appareils électroniques. Les fabricants ont du mal à refroidir les appareils électroniques. Il existe des méthodes de refroidissement actives et passives pour l’électronique. Un nouveau ventilateur à placer sur la puce pourrait marquer une nouvelle avancée dans le domaine du refroidissement actif.

Refroidissement sur puce

Le ventilateur a été développé par xMEMS Labs, une société qui se spécialise dans la conception de pilotes stéréo pour les appareils audio. L’entreprise a appliqué la même technologie MEMS (systèmes micro-électromécaniques) au ventilateur, qui se fixe au ventilateur comme un « fan-on-a-chip ». Comme le ventilateur a une épaisseur d’à peine 1 mm, il ne prend pratiquement pas de place à l’intérieur de l’appareil.

Le ventilateur contrôle la circulation de l’air vers et depuis le processeur. Selon xMEMS, il peut déplacer jusqu’à 39 centimètres cubes d’air par seconde à une pression de 1 000 Pascal. La consommation est limitée à 30 mW.

Selon l’entreprise, le ventilateur peut être utilisé dans différents types d’appareils, des smartphones aux ordinateurs portables, voire aux casques RV. Le ventilateur est également résistant à l’eau et à la poussière (IP58). Ce sont principalement les appareils électroniques « minces » qui bénéficieront de ce système de refroidissement.

Comme la technologie utilisée est la même que celle utilisée pour les pilotes, la production a pu être lancée relativement rapidement. XMEMS Labs n’a pas sa propre usine, mais confie la production de ses pilotes à TSMC et à Bosch.

Note : il s’agit d’un article de vulgarisation consacré à une réglementation future, basé sur la publication officielle du 12/07/2024. Adressez-vous toujours à un·e juriste pour obtenir un avis juridique professionnel.

L’AI Act européen (en français le règlement sur l’intelligence artificielle) est une des pierres angulaires d’une série d’initiatives législatives à grande échelle destinées à réglementer l’économie numérique en Europe. Il vient ainsi compléter la législation antérieure relative à certains aspects de l’intelligence artificielle, comme le RGPD, le Digital Services Act (DSA) et le Digital Markets Act (DMA), le Data Act, le Data Governance Act, le CHIPS Act et le Cyber Resilience Act en cours d’élaboration. Après de longues négociations, l’AI Act a été approuvé par le Parlement européen en mars 2024 et par le Conseil européen en mai 2024. La publication au Journal officiel de l’Union européenne, que l’on peut appeler Moniteur européen, a eu lieu le 12 juillet 2024. Les premières règles entreront en vigueur début 2025. Vous pouvez également consulter cette chronologie.

Un RGPD bis ?

Le texte intégral de l’AI Act, y compris l’ensemble des préliminaires et annexes, comprend 144 pages. Fort heureusement, de bons résumés sont déjà disponibles ici et là. Il est ainsi presque deux fois plus long que le RGPD qui ne fait, lui, “que” 88 pages. L’impact de ce dernier est énorme : toutes les organisations traitant des données à caractère personnel – il suffit d’avoir une administration du personnel ou un fichier de clients – se sont en effet vues confrontées aux exigences relatives aux délégués à la protection des données, aux registres de traitement et aux bases juridiques du traitement des données. Chaque pays a également dû mettre en place une Autorité de protection des données habilitée à infliger des amendes en cas d’infraction.

Le RGPD s’est également accompagné d’une certaine confusion, notamment par son utilisation fréquente de termes ouverts à l’interprétation (“approprié”, “adéquat”, “adapté”, “suffisant”…).

La nécessité de les concrétiser à nouveau pour chaque cas d’espèce alimente ce que l’on peut aujourd’hui appeler une petite industrie juridique. L’AI Act vise à fournir un peu plus d’indications, en revêtant une forme plus technique. Il comporte ainsi une liste d’annexes avec des énumérations pratiques des attentes en matière de documentation, de conformité, de transparence, etc.

L’AI Act est parti d’une proposition plus compacte de 125 pages (annexes incluses). Au cours des négociations cependant, on a assisté à l’essor fulgurant de l’IA générative et des grands modèles de langage. Cette nouvelle donne a nécessité la révision et l’ajout de certains éléments, tels qu’un nouveau chapitre (5) entièrement consacré aux modèles d’IA à usage général, parmi lesquels on compte les grands modèles de langage. Quant à certaines sections, on peut se demander ce qu’elles viennent faire dans l’AI Act, notamment un système de “bacs à sable réglementaires de l’IA” (article 57) qui doit permettre aux régulateurs de faciliter l’innovation. Certains articles sont formulés de manière plutôt énigmatique, comme la section dédiée aux “organismes d’évaluation de la conformité notifiés” (article 29), qui ne sont ni plus ni moins que des auditeurs. Des voix critiques se font donc entendre, craignant que la somme de mesures qui en résulte ne débouche avant tout sur un véritable imbroglio.

AI Act – Fondamentaux

L’AI Act s’adresse aux développeurs et aux fournisseurs d’IA, et ce uniquement lorsqu’ils publient des systèmes d’IA et les mettent à la disposition de tiers. Tous les développements et tests internes préalables sont explicitement exemptés (article 2 §8). L’AI Act ne s’applique pas non plus aux activités personnelles auxquelles vous vous adonnez dans un contexte non professionnel (article 2 §10). De même, la recherche scientifique (article 2 §6) et les applications militaires (article 2 §3) ne sont pas concernées. Bien évidemment, cela ne signifie pas que tout est permis dans tous ces cas.

Il va de soi que d’autres législations existantes restent en vigueur. Les droits des citoyens étaient déjà protégés par l’article 22 du RGPD entre autres, tandis que la législation sur les droits d’auteur continue de protéger les auteurs.

Par ailleurs, la définition de l’IA utilisée est particulièrement large et empruntée à l’OCDE : en résumé, “un système IA […] déduit, à partir des entrées, la manière de générer des sorties […]” (article 3 + considérant 12). La quasi-totalité de l’apprentissage automatique entre dans ce cadre. Dans d’autres définitions, on lit parfois que l’IA comporte un aspect cognitif (quelque chose doit être “reconnu”), mais il n’en est pas fait mention ici. Il n’est pas non plus fait mention de techniques spécifiques : tout ce qui apprend de manière adaptative ou peut réagir de manière quelque peu autonome à l’environnement est presque toujours inclus. Il s’agit donc également des systèmes que vous connaissez depuis des années, sans vous rendre compte qu’ils reposent sur l’intelligence artificielle, tels que les filtres antispam, les recommandations sur les sites web, voire les prévisions météorologiques.

L’AI Act définit d’abord et surtout une liste de pratiques interdites (article 5), qui prendra effet dès le début de l’année 2025. Cette liste est exhaustive, ce qui signifie en principe que tout ce qui n’est pas explicitement interdit est autorisé (sauf dispositions contraires prévues par d’autres lois). Aussi est-il intéressant d’examiner ce qui figure et ce qui ne figure pas dans cette liste d’interdictions, ainsi que les dispositions supplémentaires qui s’y rapportent. On découvre ainsi que :

- §1(f) : L’interdiction de la reconnaissance des émotions ne mentionne que le lieu de travail et l’enseignement.

- §1(g) : L’interdiction des systèmes d’IA biométriques ne mentionne que la déduction automatique concernant la race, la sexualité, l’affiliation à une organisation syndicale, la religion, les convictions politiques et philosophiques.

- §1(e) : L’interdiction de la reconnaissance faciale ne concerne que les systèmes basés sur ce qu’on appelle “moissonnage non ciblé”.

Elle est donc plus nuancée qu’une liste d’interdictions générales, car le contexte et l’objectif interviennent également. La reconnaissance des émotions dans les jeux vidéo, par exemple, reste ainsi autorisée. Les considérants 15 à 17 précisent que l’IA biométrique reste autorisée pour la vérification d’identité et l’authentification. Parallèlement, des exceptions sont prévues entre autres pour l’assistance médicale et la lutte contre la criminalité, bien que ces exceptions soient soumises à un contrôle strict (article 5, §2-§7), y compris une liste des infractions pénales qui entrent en ligne de compte (annexe 2).

Les systèmes qui assurent la sécurité des utilisateurs ou qui sont énumérés à l’annexe 3 sont des systèmes à haut risque (article 6). Il s’agit principalement de systèmes susceptibles d’avoir un impact majeur sur les libertés, la vie, la carrière ou la santé d’un individu. Bien que cette section de l’AI Act n’entrera en vigueur qu’à l’été 2026, il convient de noter qu’il subsiste des lacunes à combler. Par exemple, la Commission doit encore fournir des lignes directrices précisant l’interprétation de cet article (article 6 §5) et se réserve le droit d’apporter des modifications même après coup (article 6 §6-§8, article 7).

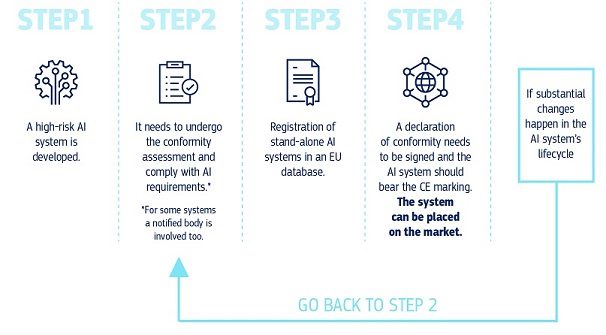

AI Act – Obligations

Quiconque souhaite construire ou a construit un système à haut risque devra se conformer à une série d’obligations, qui doivent notamment permettre aux autorités compétentes d’intervenir en cas de non-respect. Les développeurs de systèmes à haut risque devront adopter certaines pratiques, notamment :

- Un système itératif de gestion des risques (article 9), qui doit permettre d’identifier et d’évaluer les risques et d’atténuer les abus potentiels à l’avance. Le texte est relativement peu concret : il parle de “risques raisonnablement prévisibles” et de “mesures appropriées” sans autre précision. Ceci fera donc encore l’objet de discussions, mais dans la pratique, on peut déjà aujourd’hui se contenter en partie des normes récemment élaborées à cette fin, telles que la norme ISO/IEC 42001. Étant entendu qu’elle n’est pas explicitement conçue pour la loi sur l’IA Act, des mesures supplémentaires peuvent s’imposer.

- La gestion de données de qualité (article 10), qui se résume en grande partie à la transparence sur l’origine, les limites, les marges d’erreur et la représentativité. L’utilisation de Data Sheets (fiches de données), dont c’est l’objectif, est devenue populaire dans le secteur au cours des dernières années.

- Fournir une documentation technique conforme aux exigences de l’annexe 4 (annexe 11 pour l’IA à usage général). Ceci est quelque peu analogue aux Model Cards (cartes modèles) que l’on peut trouver sur le HuggingFace Hub, bien que la Commission européenne ne se contente pas de listes cochées et exige plus de détails, y compris sur la surveillance et le contrôle pendant la durée de vie du système.

- L’enregistrement (article 12) ainsi que la transparence et la fourniture d’informations aux utilisateurs (article 13).

- Le contrôle humain pendant la durée de vie du système (article 14). Si l’article 22 du RGPD en faisait déjà un droit civil, l’AI Act impose aux développeurs de prendre les mesures nécessaires à cette fin. Par exemple, il devra toujours être possible d’ignorer, de remplacer ou d’arrêter le système d’IA (article 14 §4 (d-e)).

- Prendre des mesures “appropriées” en matière de cybersécurité, de robustesse et d’exactitude (article 15). Cet article reste lui aussi relativement vague à l’heure actuelle et fait référence à l’intention de la Commission de soutenir le développement des étalonnages nécessaires.

Quiconque publie, met à disposition, incorpore dans son propre produit, importe ou distribue un système à haut risque devra prendre des mesures similaires, notamment :

- Vérifier et prouver la conformité du système (article 16 §e-l, articles 40-47), établir une déclaration de conformité (annexe 5) et obtenir le marquage CE (article 48).

- Utiliser un système de gestion de la qualité (article 17).

- Conserver la documentation nécessaire pendant 10 ans après la mise en service (article 18).

- Coopérer avec les autorités compétentes (article 21).

- Enregistrer le système (article 49) dans une base de données européenne dédiée (article 71).

- Désigner une personne de contact ou un représentant pour tout ce qui précède (article 22).

- Mettre en place la surveillance nécessaire et agir en cas de problème (article 26 §5 et articles 72-73), notamment en informant l’autorité compétente.

Par analogie avec l’analyse d’impact relative à la protection des données du RGPD, certaines organisations, dont toutes les autorités publiques et les organisations de service public, devront réaliser une analyse d’impact sur les droits fondamentaux (Fundamental Rights Impact Assessment ou FRIA) dont les résultats devront être communiqués aux régulateurs du marché compétents (article 27). L’AI Office européen est déjà chargé de développer les questionnaires automatisés nécessaires à l’acquittement de cette obligation (article 27 §5).

On en oublierait presque que la grande majorité des systèmes d’IA sont simplement des systèmes à faible risque. À cet égard, l’AI Act est assez succinct : ils doivent satisfaire à des exigences minimales de transparence uniquement pour des applications spécifiques (article 50). Ainsi, l’utilisateur final doit toujours savoir qu’il interagit avec un système d’IA, et les résultats générés artificiellement doivent être clairement identifiés comme tels. La mainmise redoutée sur l’ensemble de l’industrie de l’IA est donc toute relative.

IA à usage général

Le développement récent de l’IA générative à usage général pour le texte et les images a nécessité l’ajout d’une catégorie distincte de systèmes, à savoir l’IA à usage général. La Commission européenne considère que ce type d’IA, indépendamment d’un éventuel risque élevé en matière de droits civils, peut également présenter un risque systémique (article 51). Le bien-fondé ou non de cette position fait l’objet d’un débat acharné dans les cercles techniques et philosophiques, mais l’UE adopte une approche prudente et prévoit un bâton juridique.

La Commission européenne se donne la liberté de déterminer les systèmes qui présentent un tel risque (article 51 §1). Bien qu’elle affirme appliquer des critères objectifs pour ce faire (annexe 13), il n’y a pas de véritable formule. Néanmoins, l’article 51 §2 fixe étonnamment une limite très concrète, à savoir qu’à partir du moment où son entraînement requiert une puissance de calcul de 1025 FLOPS, un modèle d’IA à usage général est par définition considéré comme présentant un risque systémique. Cela correspond approximativement à un temps d’entraînement d’un an sur un cluster de 4000 GPU de type Nvidia RTX4090 (avec une puissance de calcul de 82×1012 FLOPS). Pour éviter que tout cela ne devienne obsolète demain, la Commission se réserve le droit d’adapter ces valeurs à l’avenir en fonction des évolutions du domaine (article 51 §3).

Outre les exigences minimales de l’article 50 et indépendamment de la classification des risques, l’IA à usage général est soumise à son propre ensemble d’exigences en matière de documentation technique (article 53, annexe 11), qui seront un peu élargies en présence d’un risque systémique (article 55). Les constructeurs de modèles d’IA à usage général sans risque systémique publiés sous licence libre sont exemptés de certaines obligations (article 53 §2, voir également les considérants 102 à 104) et ne sont pas non plus tenus de désigner une personne de contact ou un représentant (article 54 § 6).

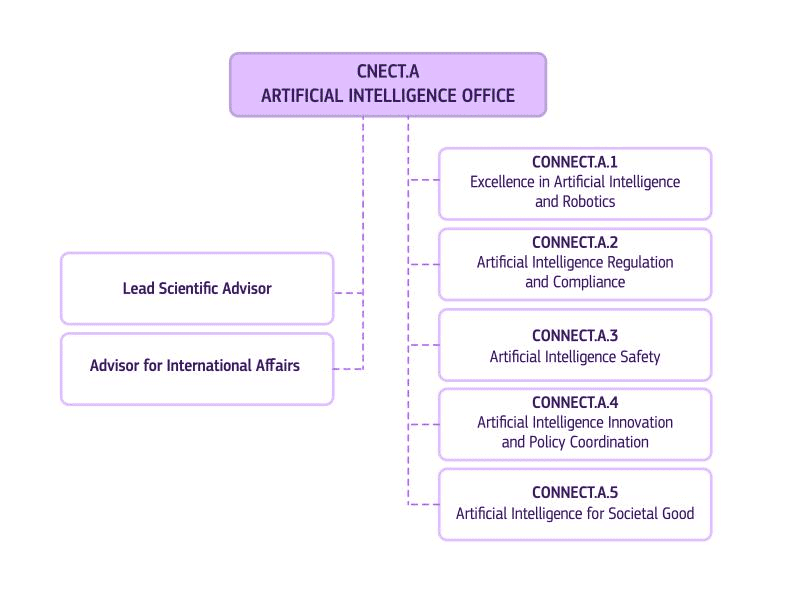

AI Office (Bureau de l’IA)

L’AI Act devra également être appliqué. Un rôle majeur dans ce cadre sera joué par l’AI Office (Bureau de l’IA, article 64), qui devrait être à l’AI Act ce que le Contrôleur européen de la protection des données est au RGPD. L’AI Office est actuellement mis en place à grande vitesse, les premières dispositions entrant en vigueur début 2025. Outre la responsabilité de compléter une série d’articles en suspens de l’IA Act, l’AI Office se verra confier la compétence exclusive de la surveillance de l’IA à usage général (article 75).

En pratique, l’AI Office fera partie de la DG CONNECT, commencera avec 140 collaborateurs et sera dirigé par Lucilla Sioli. Il sera soutenu dans son fonctionnement par le Centre européen pour la transparence algorithmique (ECAT), un Comité AI (article 65), un forum consultatif des parties prenantes (article 67) et un groupe scientifique d’experts indépendants (article 68).

Des régulateurs doivent également être désignés au niveau national (article 70). Ils devront travailler en étroite collaboration avec l’AI Office de l’UE et avec les régulateurs industriels et sectoriels existants, qui aujourd’hui sont déjà responsables du marquage CE, par exemple. Aux Pays-Bas, l’Autoriteit Persoonsgegevens joue clairement un rôle de pionnier dans la mise sur pied d’une autorité néerlandaise de l’IA, qui sera probablement établie dans le giron de l’Autoriteit Persoonsgegevens. En Belgique, la situation reste calme, même si le temps presse. En effet, on ne peut pas non plus engager n’importe qui pour occuper ces fonctions assez spécialisées.

Conclusion

Il est important de retenir que l’AI Act n’impose aucune restriction aux systèmes d’IA à faible risque, à l’exception de l’IA à usage général qui requiert la transparence nécessaire. Ce n’est que pour les systèmes à risques élevés ou systémiques et mis en production qu’interviennent des exigences strictes et la nécessité de se conformer aux réglementations pertinentes. Même dans ce cas, de nombreuses mesures d’atténuation offrent une marge de manœuvre supplémentaire au développement interne, aux initiatives open source, à la science, à la défense, etc.

Dans une certaine mesure, l’AI Act se veut concret, par une énumération détaillée des attentes et la mention de diverses précisions dans les considérants et les annexes. Il y parvient en partie et devient ainsi assez technique, de sorte qu’un juge concerné devra apprendre ce que sont les FLOPS. Parallèlement, il subsiste de nombreuses lacunes à combler et il reste à voir où le nouvel AI Office placera la barre dans les futures Commissions. La possibilité de modifier ultérieurement l’IA Act a été envisagée ici et là. La version actuelle de l’IA Act ne sera donc certainement pas la dernière.

Enfin, en Belgique, il ne s’agit pas d’attendre trop longtemps pour désigner et organiser le(s) régulateur(s) national(aux) pour l’AI Act si l’on veut être un tant soit peu en phase avec le reste de l’Europe. Pour obtenir des outils pratiques qui peuvent, entre autres, vous aider à vous mettre en conformité, vous pouvez d’ores et déjà consulter la base de données du Kenniscentrum Data & Maatschappij. De nombreux autres documents y seront certainement publiés lorsque l’AI Act entrera effectivement en vigueur.

Cette contribution a été soumise par Joachim Ganseman, consultant IT chez Smals Research. Elle a été rédigée en son nom propre et ne prend pas position au nom de Smals.

Grâce à une nouvelle fonction de stockage, les liens WeTransfer resteront désormais actifs jusqu’à 30 jours. Pour les utilisateurs gratuits, la limite est de sept jours.

Tout le monde le connaît : on reçoit un lien WeTransfer par mail mais on oublie de télécharger les fichiers. Après quelques jours, on constate que le lien n’est plus valide et on doit admettre sa faute et demander de renvoyer le lien. Désormais, WeTransfer alloue plus de temps pour télécharger les fichiers d’un lien.

Dans un message publié sur X, WeTransfer a annoncé qu’il augmentait la période d’expiration des liens. La communication de l’entreprise était plutôt confuse, car le message donnait l’impression que les liens n’expireraient plus du tout. Pour être clair, ce n’est pas le cas, mais la période d’expiration passe à un maximum de 30 jours.

Save for later

WeTransfer propose une nouvelle fonction baptisée Save for Later, qui apparaîtra à côté du bouton de téléchargement quand on reçoit un lien. Cette fonction sauvegarde le lien de téléchargement comme un favori dans le navigateur. Ainsi, la date d’expiration du lien peut être prolongée de quelques jours à 30 jours. Bien entendu, il faut toujours penser à télécharger les fichiers, car après trente jours, le lien disparaît.

Par ailleurs, la limite de 30 jours est réservée aux utilisateurs payants. Mais les utilisateurs gratuits bénéficient aussi d’un peu plus de temps pour télécharger les liens WeTransfer. TechCrunch a déjà testé la fonctionnalité avec un compte gratuit et a pu télécharger des fichiers jusqu’à sept jours après leur envoi.

La société néerlandaise WeTransfer est récemment rachetée par la société italienne Bending Spoons. La plateforme de partage de fichiers compte 80 millions d’utilisateurs actifs, dont 600 000 payants.

Eric Schmidt, ancien PDG de Google, a déclaré des choses frappantes au sujet de l’IA lors d’une conférence donnée dans une université américaine. Par exemple, il semble n’avoir aucun problème à copier des applications avec leur contenu à l’aide de LLM.

Schmidt était l’invité de la prestigieuse université de Stanford. C’est une visite dont Schmidt se souviendra longtemps, car l’ancien PDG de Google et de sa société mère Alphabet (de 2001 à 2015) y a fait des déclarations remarquables. Au point que l’université a rapidement retiré la vidéo, bien que des extraits circulent sur les médias sociaux.

Il a notamment parlé des possibilités qu’offrent les LLM pour le développement d’applications. Des fenêtres contextuelles plus grandes et des capacités améliorées de « texte à l’action » simplifieront le développement d’applications. À l’aide d’un exemple, il a voulu montrer comment on pouvait créer rapidement « le nouveau TikTok », la plateforme de médias sociaux critiquée aux États-Unis.

« Demandez à un LLM une copie de l’application, puis copiez tous les utilisateurs et le contenu. Donnez quelques préférences personnelles et demandez au LLM de créer le programme en 30 secondes. Si l’application n’est pas encore devenue virale au bout de quelques heures, modifiez-la. »

Droits d’auteur, c’est quoi ?

Plus tard dans la conversation, Schmidt semble réaliser soudainement qu’il existe des droits d’auteur et ajoute qu’il ne veut pas appeler à la copie illégale de musique. Mais il ne pense pas non plus que les start-ups doivent être arrêtées par cette loi. Il est tout à fait simple : embauchez quelques avocats « pour nettoyer le chaos ». « Si personne n’utilise votre application, le fait que vous ayez volé du contenu n’a pas vraiment d’importance », a ajouté Schmidt.

De nombreux juristes seront stupéfaits par ses propos. Bien entendu, ce que dit Schmidt est tout à fait incorrect. Le fait que le contenu soit accessible au public sur l’internet ne signifie pas qu’il n’est pas soumis au droit d’auteur, quoi qu’en pensent les entreprises technologiques. On ne peut donc pas simplement « couper et coller » une application avec un LLM.

Les LLM ne sont pas contestés en raison de la manière dont les entreprises qui les utilisent gèrent les droits d’auteur. Pour entraîner les modèles, des données accessibles au public ont été injectées dans les LLM sans tenir compte des droits d’auteur et des frais. Bien qu’OpenAI et Google aient récemment conclu des accords pour permettre l’utilisation du contenu, ce n’est qu’un petit baume sur la plaie ouverte.

Le télétravail, c’est perdre

Et ce n’est pas tout. Schmidt a aussi présenté une analyse intéressante des raisons pour lesquelles son ancien employeur, Google, a du mal à rivaliser avec des start-ups comme OpenAI et Anthropic dans le domaine de l’IA. Il explique que la politique de télétravail de Google freine l’entreprise.

» Google a décidé que l’équilibre entre vie professionnelle et vie privée et le travail à domicile étaient plus importants que la réussite. Les start-ups ont du succès parce que les gens travaillent beaucoup plus dur », explique-t-il. Voilà une vision assez démodée. La vidéo de la conférence aurait été retirée de YouTube à la demande de Schmidt.

Est-ce que votre PC est incompatible avec la norme TPM 2.0 obligatoire pour Windows 11 ? Bientôt, il ne sera plus possible d’installer Windows 11 à l’aide d’une porte dérobée.

Depuis les premiers jours de Windows 11, un TPM 2.0 (« Trusted Platform Module ») est nécessaire pour passer à la (aux) dernière(s) version(s). Mais vouloir est trouver une porte dérobée ; il existait donc un moyen d’installer Windows 11 sans TPM. Lors d’une prochaine mise à jour de Windows, Microsoft y mettra le holà.

Un utilisateur X nommé Bob Pony a remarqué dans une mise à jour Canary que Microsoft va encore renforcer les exigences pour Windows 11. Via une installation setup.exe, il était possible de contourner le point de contrôle, mais cette porte dérobée sera définitivement fermée. Si Windows ne peut pas détecter un TPM 2.0 dans l’appareil, le système ne fonctionnera pas.

Tenir bon

Avec ses exigences strictes en matière de matériel, Microsoft a exclu de nombreux PC de Windows 11. On ne sait pas toujours pourquoi ces exigences existent, mais Microsoft tient bon, même si les restrictions empêchent l’adoption de Windows 11. Windows utilise le TPM 2.0 pour intégrer le chiffrement BitLocker au niveau du matériel.

Outre TPM 2.0, le processeur du PC doit être assez récent, par exemple, et il doit y avoir suffisamment de mémoire. Quelques autres exigences que Microsoft insiste lourdement sont l’instruction POPCNT et le Secure Boot. Microsoft fermera toute porte dérobée découverte un jour ou l’autre.

La dernière version Canary de Windows 11 supprime également les restrictions. Le stockage externe ne sera plus plafonné à la limite arbitraire de 32 Go. Il reste à voir quand ces changements seront déployés à grande échelle. Entre-temps, Microsoft prépare le déploiement de Windows 11 24H2. La principale mise à jour des fonctionnalités de cette année est attendue pour l’automne.

La limite arbitraire de 32 Go dans Windows 11 sera retirée. Dans la dernière version de Canary, il est possible d’utiliser un stockage externe formaté en FAT32 jusqu’à 2 To.

La lecture du stockage externe dans l’Invite de commande inclut depuis des années une limite fixe de 32 Go. Mais pourquoi ce chiffre ? Personne ne le sait. Microsoft ne comprend apparemment pas non plus l’intérêt d’une telle limite. Dans la dernière version Canary de Windows 11, une phase bêta précoce pour les initiés de Windows, la limite est supprimée. La nouvelle limite est de 2 To.

Auparavant, les systèmes Windows pouvaient encore lire des systèmes de fichiers FAT32 plus volumineux malgré cette limite artificielle de 32 Go, selon Bleeping Computer. La seule condition était qu’ils aient été créés sur d’autres systèmes d’exploitation ou par d’autres méthodes (par exemple, à partir d’une invite Windows PowerShell avec des droits d’administrateur ou à l’aide d’applications tierces qui ignoraient cette limite artificielle).

Après une période de test dans la version Canary, la nouvelle limite devrait être intégrée dans les versions bêta moins expérimentales des Windows Insiders avant d’être déployée à grande échelle pour tous les utilisateurs. Les testeurs de la version Canary doivent mettre à jour leur version de Windows vers Windows 11 Insider Preview Build 27686.

Important : un outil de formatage de disque Windows basé sur le GUI maintient toujours la même limite artificielle de 32 Go pour les systèmes de fichiers FAT32. La taille maximale des fichiers reste de 4 Go avec FAT32.

MMD lance les écrans Philips 34B2U6603CH et Philips 34B2U5600C. Ces deux écrans prennent en charge l’USB-C, ont une résolution WQHD et sont destinés au marché professionnel.

MMD, qui fabrique des moniteurs sous la licence de la marque Philips, présente deux nouveaux écrans. Il s’agit du Philips 34B2U6603CH et du Philips 34B2U5600C, qui complètent respectivement la gamme 6000 et la gamme 5000 du fabricant.

Les deux nouveaux écrans partagent la même diagonale de 34 pouces avec une résolution de 3 440 x 1 440 pixels. Les écrans ont un rapport d’écran ultra-large de 21:9, avec suffisamment de pixels pour afficher deux fenêtres de programme côte à côte sans compromis. MMD opte pour un panneau avec une courbe. Les écrans sont équipés d’un support qu’on peut régler en hauteur et en orientation.

Connectivité

Le Philips 34B2U6603CH est la version la plus haut de gamme, et dispose d’un port USB-C/Thunderbolt 4 avec prise en charge d’une charge de 100 watts via la norme Power Delivery. Un port RJ-45 2,5G est un ajout assez exceptionnel, permettant une connectivité Ethernet très rapide.

Le Philips 34B2U5600C est la variante la plus classique. Il est équipé d’un hub USB-C classique avec prise en charge de l’USB 3.2, mais pas de l’USB 4/Thunderbolt 4. Le port RJ-45 ne prend en charge que des vitesses de 1G, ce qui est largement suffisant dans la plupart des environnements de bureau ou domestiques. Cet écran peut également charger un ordinateur portable.

MMD intègre une webcam pop-up avec un capteur 5MP et une lumière liée à Microsoft Teams. Ainsi, vos collègues pourront voir votre état de disponibilité sur votre écran. La webcam prend en charge le cadrage automatique et la réduction du bruit. Le son provient de deux haut-parleurs intégrés de 2 W.

Les modèles Philips 34B2U6603CH et 34B2U5600C sont désormais disponibles aux prix de vente conseillés de 649 euros et 549 euros TTC, respectivement.

Michael Sentonas, président et directeur technique de Crowdstrike, était personnellement venu à Def Con pour recevoir le prix de la « pire catastrophe » (« Most Epic Fail ») après une mise à jour catastrophique qui a fait planté des millions d’ordinateurs.

Mi-juillet, une bonne partie du monde s’est soudainement arrêtée. Une mise à jour de Crowdstrike a détruit des PC Windows dans le monde entier, y compris ceux de la SNCB et de Brussels Airport. Le même jour, les équipes informatiques ont reçu une solution temporaire pour rétablir les PC. Quatre jours plus tard, un simple outil de récupération a corrigé la situation.

Aujourd’hui encore, tous les détails concernant le bogue sont disponibles sur le portail de récupération que Crowdstrike a établi pour aider le plus grand nombre possible de personnes affectées. Plus de 8,5 millions de PC Windows auraient été affectés par la mise à jour défectueuse. Au total, la panne aurait coûté plus de 5 milliards de dollars à l’économie mondiale.

Le PDG et fondateur de Crowdstrike s’est excusé publiquement à maintes reprises pour cette erreur. Le directeur technique et président de Crowdstrike, Michael Sentonas, est lui-même allé plus loin en participant à la conférence Def Con. Chaque année, cet événement célèbre les réussites dans le monde de la sécurité, mais n’oublie pas les catastrophes.

Crowdstrike a dominé la liste et a reçu le célèbre « Pwnie Award » dans la catégorie « la pire catastrophe ».

Sentonas souligne qu’il n’est « pas fier de recevoir ce trophée ». « Néanmoins, il l’a accepté à titre personnel. Le trophée occupera une place bien visible dans notre siège social. Chaque employé le verra en venant travailler. »

La nouvelle fonction d’IA « Prendre des notes pour moi prend » des notes lors des réunions dans Google Meet.

Google lance une nouvelle fonction d’IA dans Google Workspace qui prend des notes au cours d’une réunion dans Google Meet. La fonction « Prendre des notes pour moi » est similaire à Duet AI. de Google. C’est aux administrateurs de décider quels utilisateurs auront accès à cette fonction dans les paramètres. Elle est déployée progressivement et n’est disponible que pour les clients avec un compte Gemini Enterprise, Gemini Education Premium ou réunions IA et comptes complémentaires de messagerie.

Prendre des notes pour moi

Dans un nouveau blog, Google décrit comment Gemini dans Meet peut prendre et résumer des notes. Elles sont enregistrées à la fin de la réunion et peuvent être partagées avec tous les participants via Google Documents. Les utilisateurs qui rejoignent la réunion plus tard peuvent également lire les notes pour reprendre plus rapidement la partie manquée de la réunion.

Cette nouvelle fonctionnalité d’IA est alimentée par le modèle d’IA Gemini de Google. Elle est très similaire à la fonctionnalité Duet AI de Google, un assistant IA qui assiste dans diverses applications de Workspace.

Comment faire ?

Pour utiliser cette fonctionnalité dans Google Workspace, ouvrez meet.google.com sur votre ordinateur et démarrez une réunion Google Meet. Cliquez ensuite sur l’icône en forme de crayon de l’option Prendre des notes pour moi en haut à droite. La fonctionnalité est lancée et les autres participants sont avertis que vous prenez des notes.

Les administrateurs décident si leurs utilisateurs ont accès à cette fonction d’IA. Pour ce faire, accédez à Applis > Google Workspace > Google Meet > Paramètres Gemini. Selon Google, la fonction « Prendre des notes pour moi » sera déployée progressivement à partir du 13 août. Elle n’est disponible que pour les clients avec un compte Gemini Enterprise, Gemini Education Premium ou réunions IA et comptes complémentaires de messagerie.

OpenAI ouvre son modèle DALL-E 3 aux utilisateurs gratuits de ChatGPT, mais avec une limite de deux images par jour.

Désormais, les utilisateurs gratuits de ChatGPT peuvent générer des images avec DALL-E 3. Jusqu’à présent, la technologie était réservée aux abonnés payants de ChatGPT-Plus. Ils peuvent générer jusqu’à cinquante images par jour, alors que les utilisateurs gratuits de ChatGPT sont limités à deux images DALL-E 3 par jour.

Deux images

OpenAI a annoncé dans un post sur X qu’à partir de maintenant, les utilisateurs gratuits de ChatGPT peuvent générer jusqu’à deux images par jour avec DALL-E 3. Par exemple, les utilisateurs peuvent demander à générer une image pour un diaporama, personnaliser une carte ou montrer à quoi quelque chose ressemble, selon le post sur X.

Les abonnés payants peuvent demander jusqu’à 50 images par jour. Pour les utilisateurs qui ne génèrent pas souvent d’images, deux par jour est encore une bonne solution. Sauf si on le compare à la version gratuite de Microsoft Copilot, qui permet de générer un maximum de 15 images par jour.

Western Digital sort des cartes SD et des disques SSD portables pour le grand public avec des capacités impressionnantes.

La société de stockage Western Digital lance une série de nouveaux produits aux capacités impressionnantes. Par exemple, les disques durs flash destinés aux centres de données auront une capacité de stockage allant jusqu’à 128 To. Le grand public bénéficie lui aussi d’une série de nouveaux produits. Par exemple, Western Digital travaille sur des cartes MicroSD SanDisk qui auront un stockage allant jusqu’à 4 To avec la norme UHS-1 et des cartes SD plus grandes jusqu’à 8 To. On ne sait pas encore quand elles seront disponibles.

De grandes capacités

Dans un communiqué de presse de Western Digital, la société lance la première carte SanDisk 4 To microSDUC UHS-I et la première carte SanDisk 8 To SDUC UHS-I. Ces produits ont été annoncés avant l’événement qui se déroule actuellement à Santa Carla, FMS. Ces cartes SD haute performance sont conçues pour les smartphones, les appareils de jeu, les drones, les appareils photo et les ordinateurs portables de demain.

De plus, une version de 16 To du SanDisk Desk Drive est aussi prévue pour les ordinateurs de bureau et les ordinateurs portable, soit le double de la capacité du plus grand disque SSD externe actuellement vendu par l’entreprise. Western Digital travaille également sur la toute première preuve de concept portable de 16 To. Pour les centres de données, des disques de stockage flash d’une capacité allant jusqu’à 128 To sont en préparation.

On ne sait pas encore si et quand ces produits apparaîtront dans les magasins. Et si vous êtes intéressé, il faut déjà commencer à économiser. Un disque dur de bureau SanDisk de 8 To coûte actuellement 700 dollars.

Un juge américain estime que Google a créé un monopole illicite autour de son moteur de recherche. La concurrence n’a aucune chance de réussir en raison des accords de plusieurs milliards de dollars conclus par Google.

Hier, le tribunal de Washington a prononcé son verdict dans le cadre d’un procès antitrust intenté contre Google. Entamée à l’époque où Donald Trump était encore président, cette action en justice a abouti à une conclusion négative pour Google. Le jugement qualifie Google de « monopoleur » qui a déstabilisé la concurrence sur le marché de la recherche en concluant de nombreux accords d’une valeur de plusieurs milliards de dollars pour préserver l’activité de son moteur de recherche.

Moteur de recherche, c’est Google. Son moteur de recherche est de loin le plus utilisé. Il existe d’autres solutions, mais son principal concurrent, Bing, ne détient même pas 4 % du marché, alors que Google en détient 90 %. Selon Google, sa domination en matière de recherche découle simplement du fait qu’il a le meilleur produit, mais le tribunal a une opinion contraire.

Des complices

Le jugement de Google repose sur plusieurs accords d’une valeur d’un milliard de dollars conclus avec d’autres parties, qui ont été révélés au cours du procès. Google a été de mèche avec les fabricants de smartphones, les navigateurs web et les opérateurs de télécommunications pour faire avancer son moteur de recherche. Pour ce faire, Google a voulu payer cher : elle a versé à Apple plus de 20 milliards de dollars par an pour obtenir le privilège d’être le moteur de recherche par défaut de Safari.

Ce faisant, Google a illégalement renforcé sa position sur le marché, a déclaré le tribunal. Tous les concurrents ambitieux étaient obligés de suivre les offres de milliards de dollars.

Le Financial Times décrit cette décision comme une victoire significative pour les décideurs politiques dans le combat contre les grandes entreprises technologiques. La nature exacte de la sanction ne sera décidée qu’à l’issue d’une audience ultérieure. Outre une lourde amende, le tribunal pourrait également exiger des solutions « structurelles », telles que la scission d’Alphabet, la société mère de Google.

Faire appel

Depuis, Google a réagi à la sentence. Avec un brin de sarcasme, l’entreprise voit dans cette décision la confirmation qu’elle dispose du meilleur moteur de recherche, « mais conclut que nous ne devrions pas le rendre facilement accessible », a déclaré Kent Walker, vice-président chargé des affaires internationales, à X.

Il est plus que probable que Google fera appel de cette décision. Le procès risque alors de durer plusieurs années. Google et les décideurs politiques américains se croiseront bientôt à nouveau le fer. Google fait actuellement aussi l’objet d’un autre procès concernant sa position dominante sur le marché de la publicité numérique.

Eset lance une solution AMF basée sur le cloud pour aider les grandes et petites organisations à supprimer les comptes avec uniquement un mot de passe.

Eset présente une version cloud d’Eset Secure Authentication (ESA) intégrée à l’écosystème Eset Protect Platform. Les clients d’Eset peuvent renforcer la sécurité de leur connexion grâce à une solution intégrée d’authentification multifactorielle (AMF).

Grâce à cette approche, l’utilisation est plus agréable et la gestion de plusieurs systèmes de sécurité est simplifiée. La solution permet donc également aux fournisseurs de services gérés de contrôler efficacement le déploiement de l’AMF dans plusieurs entreprises ou sites.

Une prise en charge très large

La version cloud d’ESA est conçue pour prendre en charge un large éventail de méthodes d’authentification, créant ainsi une solution rentable pour les entreprises de toutes tailles, selon Eset. Le spécialiste de la sécurité cherche à chaque fois à soutenir les petites organisations avec ses nouvelles solutions.

Avec cette version d’ESA basée sur le cloud, les entreprises peuvent facilement déployer l’AMF sans nécessiter de matériel local. Eset Secure Authentication prend en charge des systèmes courants tels que les VPN, le protocole de bureau à distance, Outlook Web Access et bien d’autres encore. Le système d’authentification fonctionne avec diverses technologies telles que les applications mobiles avec notifications push, les jetons matériels et les clés FIDO, pour aider les entreprises à répondre aux exigences de conformité et à éviter les violations de données.

La version cloud d’Eset Secure Authentication est disponible avec un abonnement à Eset Protect Elite, ainsi qu’en tant que solution autonome sans changement de prix. Pour accéder à la version cloud, les clients doivent avoir un compte dans le nouveau Eset Proect Hub : la passerelle centrale vers la plateforme de sécurité d’ESET.

La panne massive d’Azure de mardi a été causée par une attaque DDoS. Microsoft avoue que ses mécanismes de sécurité ont failli à leur tâche.

Mardi, plusieurs portails Azure, dont Entra et Intune, se sont déconnectés pendant plusieurs heures. Sur sa page d’état, Microsoft a indiqué qu’une attaque DDoS était en cause. Un « pic d’utilisation inattendu » a provoqué une saturation du système CDN, ce qui a entraîné des pannes de réseau. Mardi soir, les problèmes ont été résolus.

Erreur d’implémentation

Une entreprise de l’envergure de Microsoft devrait être armée contre les attaques DDoS. Microsoft affirme que ses mécanismes de sécurité sont entrés en action, mais qu’une certaine erreur d’implémentation a amplifié l’attaque au lieu de la repousser. Une première analyse post-incident sera effectuée dans les 72 heures, et le rapport final suivra après 14 jours.

On ne connaît pas encore les responsables de l’attaque. Le groupe SN_blackmeta déclare être l’auteur de l’attaque. Ce groupe a déjà fait parler de lui avec une attaque DDoS contre la plateforme de médias sociaux Snapchat et une attaque qui a duré six jours contre une organisation du Moyen-Orient. On saura dans les prochains jours si ce groupe est bien l’auteur de l’attaque et quelles sont ses intentions.

Une erreur de trop

Microsoft sera blâmé pour cette erreur. Cette panne survenait à peine une semaine après le crash fatal de Crowdstrike sur Windows. Certaines entreprises touchées ne se sont pas encore complètement redressées. Cependant, Microsoft partage la culpabilité de ce crash.

Dans d’autres incidents de sécurité récents concernant des services Microsoft, le géant du logiciel a joué un rôle plus discutable. Malgré la promesse personnelle du directeur Brad Smith, l’affaire a de nouveau mal tourné cette fois-ci.

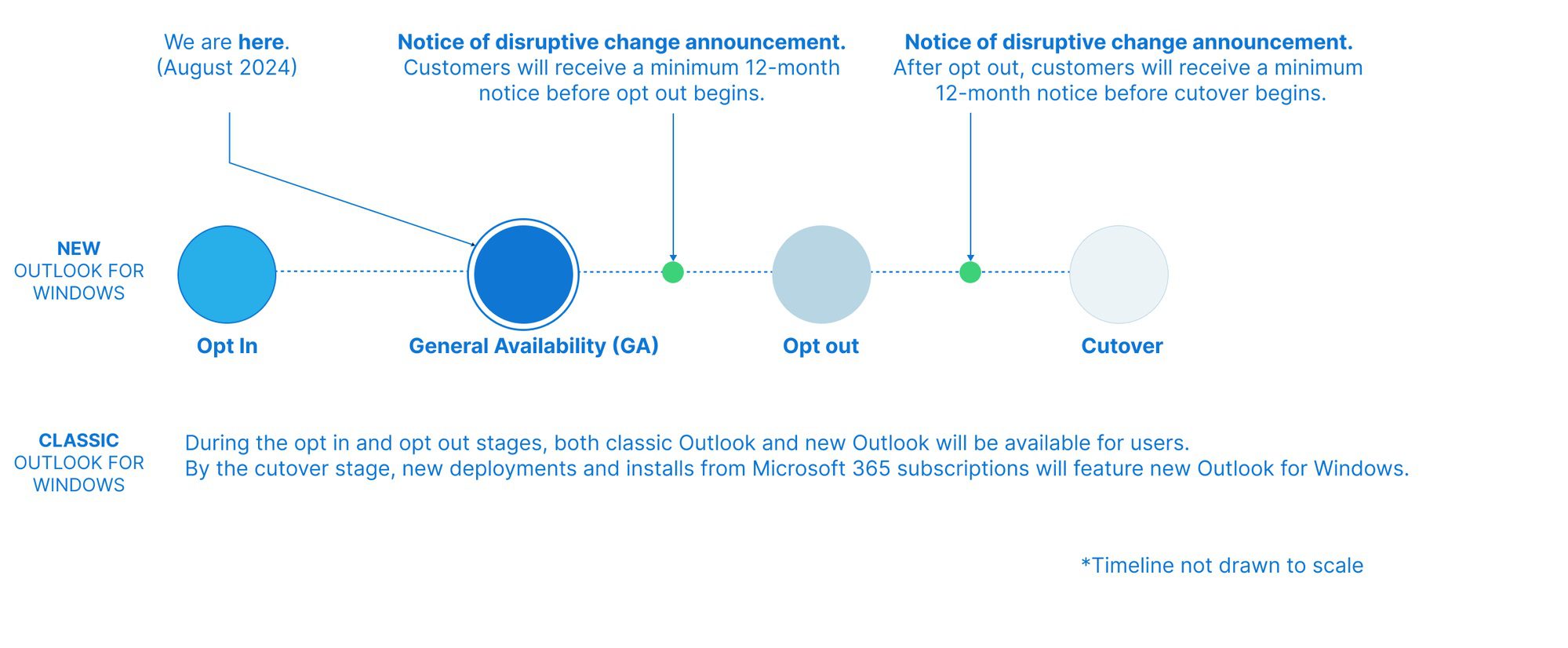

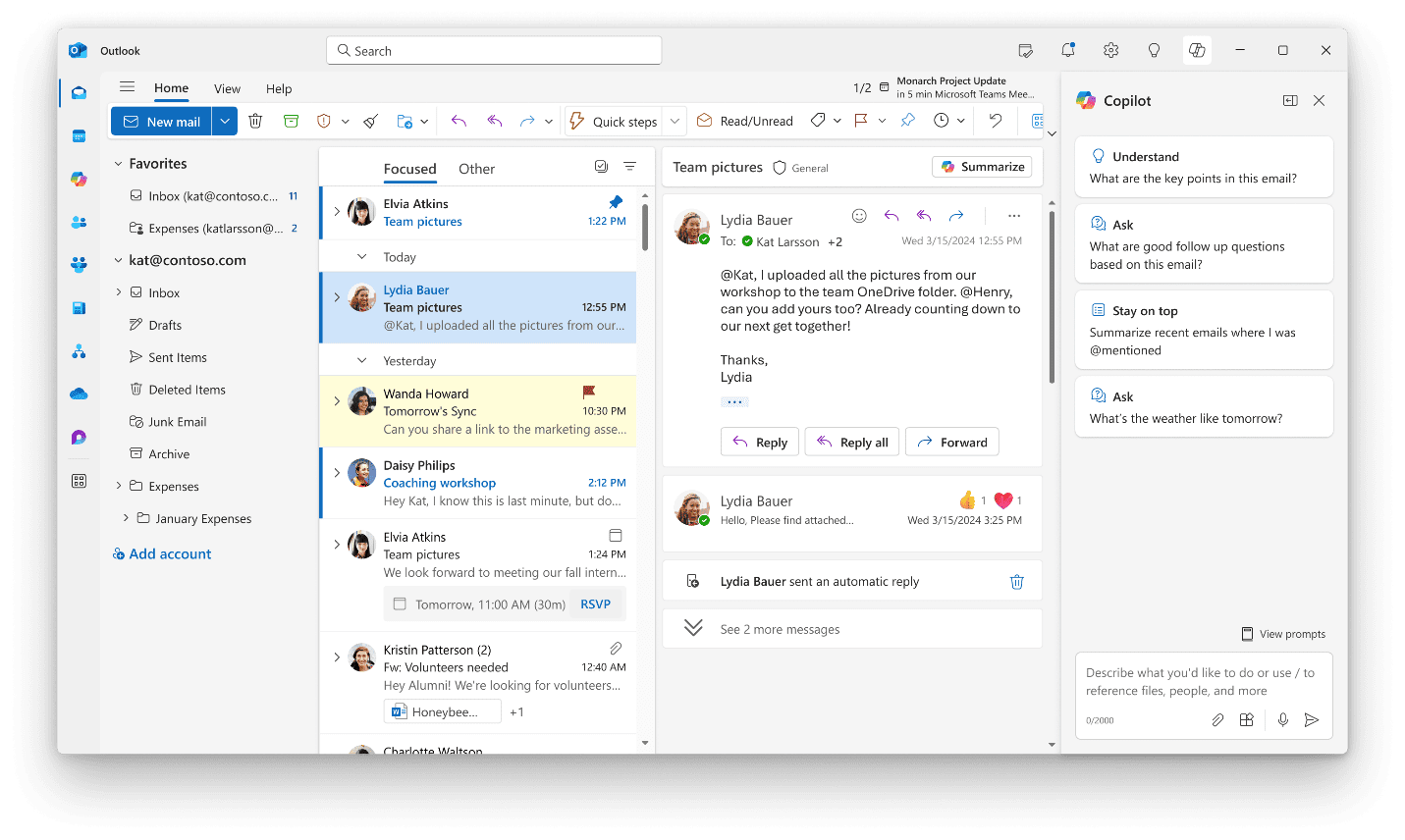

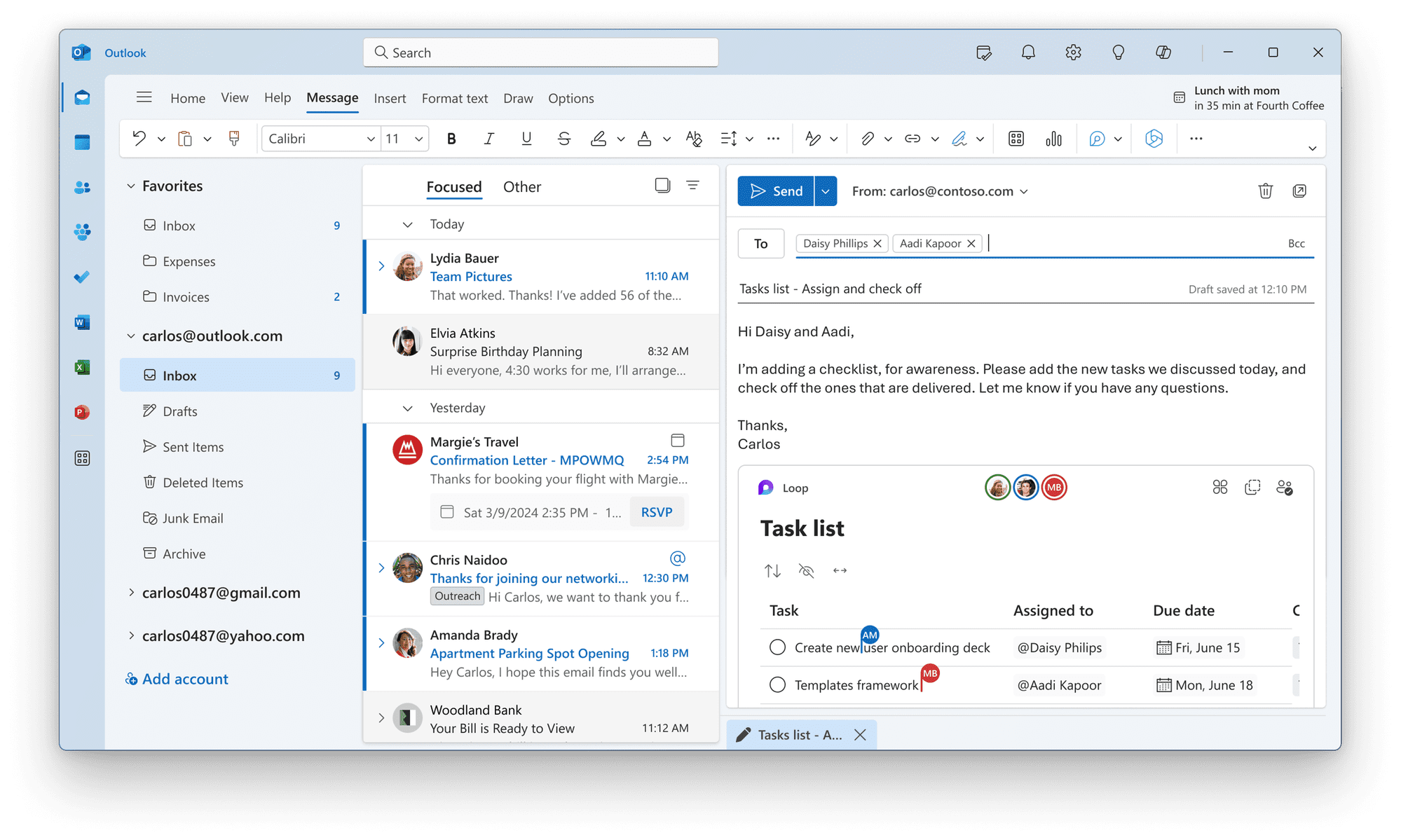

Microsoft lance la nouvelle mise à jour d’Outlook. Elle inclut l’assistant Copilot, des fonctionnalités pratiques pour organiser sa boîte de réception et l’intégration avec Teams et OneDrive.

Tous les utilisateurs chevronnés d’Outlook savent depuis longtemps que Microsoft prépare une nouvelle version d’Outlook, ou l’ont déjà testée en profondeur. Cela fait déjà un bon moment que Microsoft travaille sur une nouvelle version, permettant de rapprocher les versions web et de bureau. Le mois dernier, l’entreprise a annoncé qu’elle souhaitait que tous les utilisateurs adoptent la nouvelle version avant la fin du mois, et ce délai semble avoir été respecté.

Microsoft annonce les nouvelles fonctionnalités dans un blog. La dernière mise à jour d’Outlook comprend un assistant Copilot qui aide à rédiger et à résumer les e-mails. De plus, il y a quelques fonctions optimisées pour garder la boîte de réception bien rangée ou pour transformer les tâches en liste de choses à faire. Microsoft intègre également Teams et OneDrive pour une expérience de travail plus fluide. La dernière version d’Outlook est prête à être déployée.

De l’ancien au nouveau

Cela fait longtemps que Microsoft rêve d’une nouvelle version de son application Outlook. Jusqu’à présent, on pouvait passer de l’ancienne à la nouvelle version d’Outlook grâce à un bouton situé en haut à droite de l’application. Ainsi, on pouvait déjà essayer certaines des nouvelles fonctionnalités, et Microsoft demandait un retour d’information. Tout le monde n’a pas immédiatement été séduit par la nouvelle version, qui présentait parfois des comportements étranges.

Pour les utilisateurs nostalgiques, l’« ancienne » version d’Outlook ne disparaîtra pas avant 2029. On a donc bien le temps d’intégrer la dernière version dans sa routine de travail. À long terme, l’objectif est que chaque utilisateur passe à la nouvelle version.

Microsoft Copilot

Sans surprise, Microsoft intègre son Copilot dans la nouvelle application Outlook. On peut ainsi consulter Copilot directement dans l’application pour, par exemple, rédiger une réponse ou suggérer une réponse en fonction du contexte du message reçu. De plus, Copilot aidera à résumer les longs e-mails et on gagne du temps dans la lecture de tous les messages.

L’IA n’est pas partout

Heureusement, toutes les nouvelles mises à jour n’ont pas à voir avec l’IA. Par exemple, Microsoft ajoute une nouvelle fonctionnalité pour épingler un e-mail en haut de la boîte de réception, pour ne pas oublier d’y répondre. De plus, il sera possible de convertir rapidement les tâches d’un e-mail reçu en une liste de tâches, simplement en le glissant dans la seconde rubrique « Ma journée ».

Enfin, si on ne veut pas accepter tout de suite un événement, mais qu’on veut rester informé, il est plus facile de le suivre sans indiquer tout de suite qu’on sera définitivement présent. Microsoft améliore aussi l’intégration avec d’autres applis telles que Teams et OneDrive. Par exemple, sans changer d’appli, on pourra ajouter des fichiers à partir de OneDrive en tapant simplement « / » pour afficher les fichiers suggérés sur lesquels on a récemment travaillé.

OpenAI annonce une nouvelle fonctionnalité de mode vocal pour les conversations en temps réel avec ChatGPT. Un groupe limité d’utilisateurs payants pourra tester cette version alpha.

ChatGPT lance un nouveau mode vocal avancé en version alpha. Quelques privilégiés (utilisateurs payants de ChatGPT) pourront avoir une conversation face à face avec ChatGPT. Selon OpenAI, le chatbot comprend vos émotions et vous laisse interrompre la conversation si nécessaire.

Ce n’est pas la première fonctionnalité vocale d’OpenAI. Lors du lancement de GPT-4o en mai, l’entreprise a présenté la nouvelle fonction audio, bien que les critiques ne manquent pas. La voix semblait très proche de celle de l’actrice Scarlett Johansson, dans le film Her.

Conversation en temps réel

Il est clair qu’OpenAI n’a pas chômé après sa première présentation de la fonction vocale de ChatGPT. L’entreprise a annoncé dans un message sur X qu’elle déployait un nouveau mode vocal avancé pour certains utilisateurs payants, cette fois sans une voix qui ressemble fort à celle de Scarlett Johansson.

« Grâce au mode vocal, on peut mener des conversations plus naturelles et en temps réel, faire une pause à tout moment, et le chatbot perçoit et réagit à nos émotions », selon un message publié sur X par OpenAI. Actuellement, un cercle limité d’utilisateurs payants peut tester la nouvelle fonctionnalité. Tous les membres de ChatGPT Plus devraient avoir accès à l’ensemble des outils du mode vocal d’ici à l’automne.

Plusieurs entreprises condamnent le comportement « agressif » du robot d’indexation d’Anthropic, qui visite des sites web jusqu’à des millions de fois par jour pour collecter des données.

Pour rendre les modèles d’IA intelligents, il faut une grande quantité de données. C’est désormais un secret de polichinelle que ces données proviennent de l’internet. Les entreprises d’IA telles qu’OpenAI et Anthropic disposent de robots d’indexation, qui parcourent l’internet et collectent des informations accessibles au public. En théorie, rien n’interdit cette méthode, mais Anthropic semble aller assez loin dans ce domaine.

Kyle Wens, PDG d’iFixit, critique Anthropic dans un message publié op X. Le robot d’Anthropic aurait visité le site un million de fois en 24 heures. Et cela n’est pas tout : le site Freelancer.com a reçu 3,5 millions de visites d’Anthropic en seulement quatre heures.

Les règles de l’internet

Tant iFixit que Freelancer.com dénoncent la manière « agressive » dont Anthropic « scrape » le web. Ce n’est pas seulement parce qu’Anthropic va utiliser leur contenu, mais aussi parce qu’une activité excessive des robots d’indexation peut surcharger les serveurs.

L’affaire est allée si loin sur Freelancer.com que les administrateurs du site ont même dû mettre Anthropic sur leur liste noire. « Ils violent les règles de l’internet », dit le PDG Matt Barrie au Financial Times. Anthropic répond qu’elle examine les plaintes et que son intention n’est pas de se comporter de manière intrusive.

Les fabricants de grands modèles d’intelligence artificielle sont critiqués depuis quelque temps pour la manière dont ils traitent les données publiques sur l’internet. Le raisonnement des membres de l’industrie repose sur le principe que les données publiques peuvent être utilisées pour former des modèles. C’est un raisonnement erroné. Même sur l’internet, les droits d’auteur jouent un rôle tout aussi important.

Depuis, les entreprises d’IA ont conclu des accords de licence avec des médias d’information ou de grandes plateformes internet comme Reddit, qui gèrent et possèdent une grande quantité de contenu. Les entreprises d’IA espèrent ainsi éviter de futures poursuites judiciaires. Anthropic n’a pas encore trouvé de tels accords.

Robot.txt

En tant qu’administrateur web, il est possible de bloquer l’accès des robots d’indexation au site web. En injectant le fichier robot.txt dans le répertoire du site, on met des bâtons dans les roues des robots d’indexation. Mais ce système est encore loin d’être infaillible. En fait, il est assez facile de le contourner en « déguisant » les robots d’indexation en visiteurs légitimes.

Mistal annonce son plus grand LLM à ce jour. Mistral Large 2 a perfectionné ses connaissances en matière de codage et maîtrise jusqu’à 80 langages de programmation.

La compétition entre les modèles d’IA reprend de plus belle. Hier, c’était Meta, aujourd’hui, c’est au tour de Mistral de présenter son dernier vaisseau amiral. Avec ses 123 milliards de paramètres, Mistral Large 2 est le plus grand LLM sorti des rangs de l’entreprise française jusqu’à présent.

Le nombre de paramètres est encore bien inférieur à celui des autres LLM connus. LLama 3.1, proposé par Meta hier, a une version de 405 milliards de paramètres, par exemple. Mistral Large 2 fonctionne à la perfection sur une Nvidia H100, selon un post sur X.

Grand, mais pas le plus grand

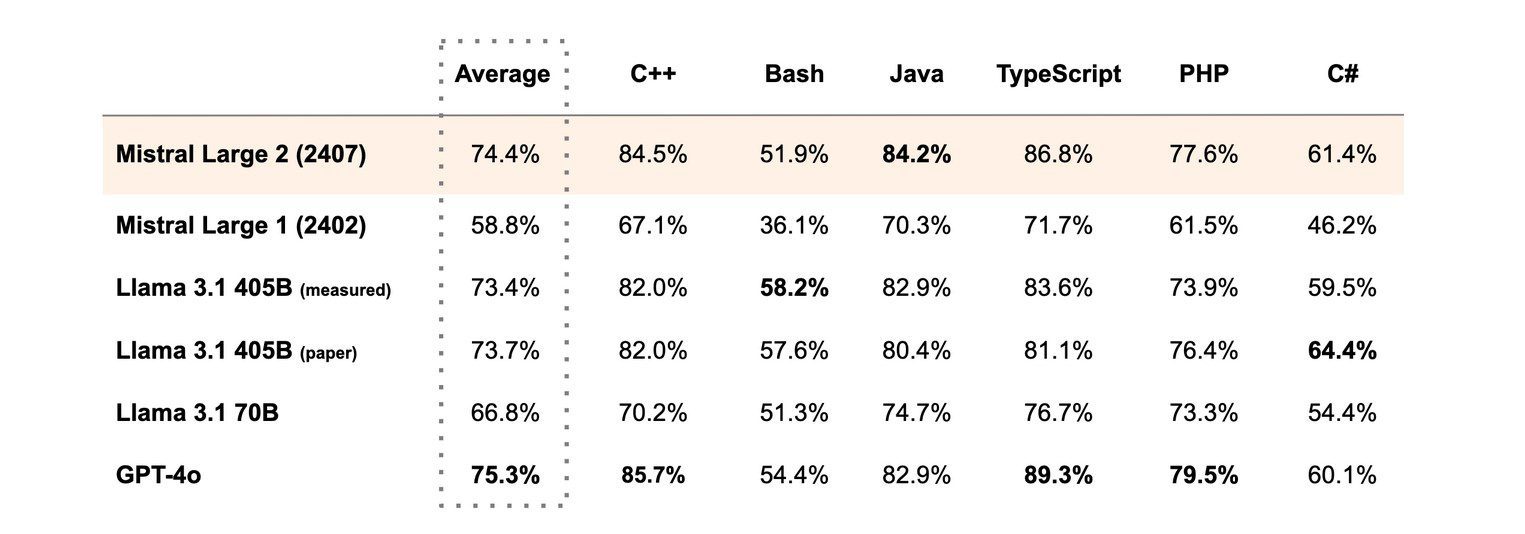

Même si le nombre de paramètres d’un modèle est révélateur de ses compétences, il y a toujours plus à découvrir. Mistral essaie de le démontrer à l’aide de tests comparatifs : elle le compare à Llama 3.1, GPT-4o et Claude Sonnet 3.5 (Google Gemini est exclu). Mistral Large 2 peut traiter autant de jetons que le modèle de Meta, jusqu’à 128 000 en une seule fois.

Mistral Large 2 a fait de grands progrès en matière de codage, explique l’entreprise dans un blog. Le premier modèle Mistral Large n’était pas un génie, mais la deuxième version maîtrise jusqu’à quatre-vingts langages, même si certains sont évidemment mieux maîtrisés que d’autres. Selon Mistral, son modèle est expert en Java.

Mistral souligne également le talent linguistique de Large 2. Le modèle parle l’anglais, le français, l’allemand, l’espagnol, le portugais, l’italien, l’arabe et le coréen, entre autres. Le néerlandais n’est pas mentionné. En revanche, Mistral Large 2 manque de capacités multimodales pour traiter simultanément des images et du texte. Il semble que ce soit la spécialité d’OpenAI.

Ouvert pour les chercheurs

Tout comme Llama 3.1, Mistral Large 2 est en principe un logiciel libre, mais tout le monde ne peut pas le télécharger gratuitement. Les chercheurs peuvent demander une licence gratuite à l’entreprise, mais pour utiliser le modèle dans le cadre d’une activité commerciale, il faut payer une contribution. Le modèle est disponible via Google Vertex, AWS BedRock, Azure AI Studio, IBM watson.x et pour le grand public via l’application de chat Le Chat.

Mistral joue un rôle marginal dans le monde de l’IA. Originaire d’Europe, l’entreprise aime exploiter ce caractère européen pour se démarquer dans un secteur dominé par les superpuissances américaines. Et Mistral est convoitée par tous. La Commission européenne a empêché Microsoft de racheter Mistral.

Microsoft et Crowdstrike pansent leurs plaies après un week-end chaotique. La mise à jour défectueuse déployée par Crowdstrike aurait affecté au moins 8,5 millions d’appareils, avec un impact énorme.

Impossible de le manquer ce vendredi : le secteur mondial de l’informatique était complètement bouleversé. La cause en était une mise à jour incorrecte de Crowdstrike Falcon Sensor sur Windows. Elle a entraîné les PC et les serveurs dans une boucle de démarrage ou sur le redoutable écran bleu de la mort.

Moins d’un pour cent

Microsoft, propriétaire de Windows, s’est également retrouvé dans une situation délicate. Dans un blog, Microsoft a évalué les dégâts. Environ 8,5 millions d’appareils Windows auraient subi l’impact de la mise à jour défectueuse Crowdstrike. Microsoft souligne que cela représente moins d’un pour cent de tous les appareils Windows dans le monde.

Il ne fallait pas plus que ce 1 % pour causer un chaos absolu. Les détaillants et les banques se sont retrouvés avec des systèmes défectueux, mais la catastrophe a été maximale dans le secteur de l’aviation en particulier. Plus de 1 400 vols ont dû être annulés dans le monde entier ; dans certains aéroports, le personnel a dû utiliser des cartes d’embarquement manuscrites.

Mieux vaut attendre