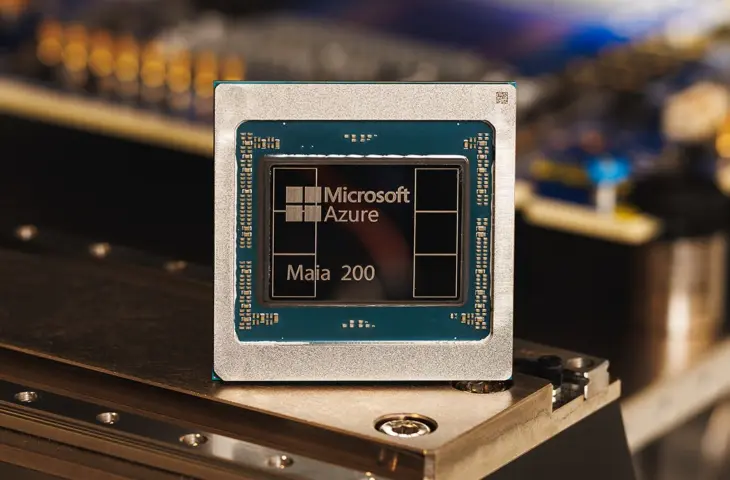

Microsoft lance Maia 200 : une nouvelle puce d’inférence IA destinée à rendre les applications d’IA à grande échelle plus efficaces et rentables au sein de l’infrastructure Azure.

Microsoft dévoile Maia-200. Il s’agit d’un accélérateur d’IA avec lequel Microsoft souhaite proposer une alternative à la génération Blackwell de Nvidia, mais aussi à l’offre d’IA d’autres acteurs du cloud. Le Maia-200 est axé sur l’inférence et doit prendre en charge les modèles d’IA tels que GPT-5.2. La puce succède à Maia de 2023.

Spécifications et pénuries de RAM

Le Maia-200 sort des chaînes de production de TSMC et est gravé selon un processus de 3 nanomètres. La puce dispose de cœurs tenseurs FP8/FP4 et fournit 10 pétaFLOPS de puissance de calcul FP4 avec un TDP de 750 watts. Ainsi, en théorie, Maia-200 offre des performances d’inférence au niveau du Nvidia B200. Selon Microsoft, le Maia 200 offre des performances FP4 trois fois supérieures à celles du Trainium 3 d’Amazon et surpasse les performances FP8 du TPU v7 de Google. Il n’est pas question pour le moment d’une comparaison avec l’architecture Rubin de Nvidia.

La puce est également dotée de 216 Go de mémoire HBM3e, avec une bande passante de 7 To/s, et de 272 Mo de SRAM sur puce. Cela permet à Maia-200 de charger de grands LLM. Le Maia-200 est donc un bel exemple de processeur d’IA qui engloutit une grande quantité de mémoire HBM. La puce illustre le rôle de Microsoft dans les pénuries actuelles de DRAM et les prix élevés qui y sont associés.

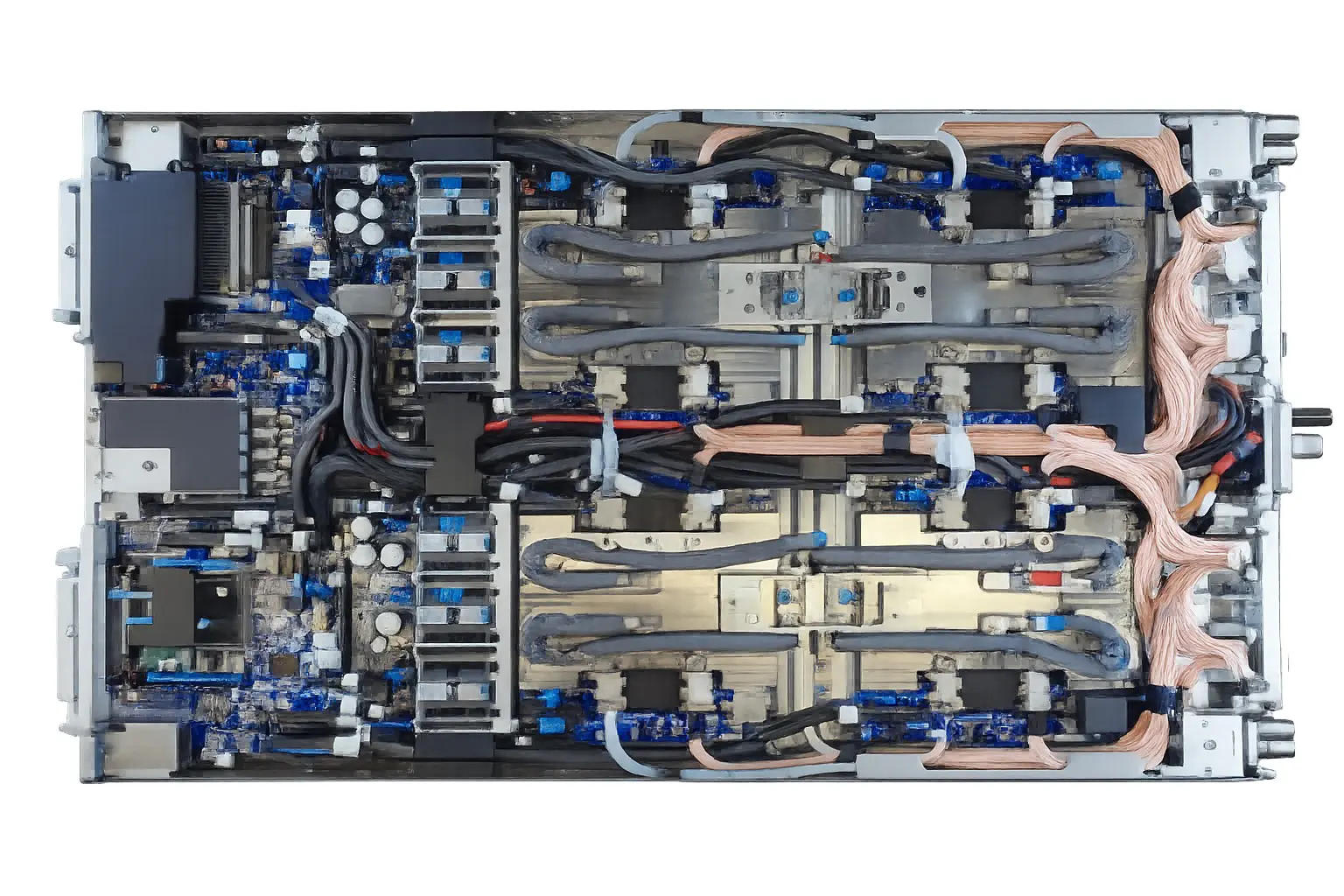

Architecture de serveur propre

Microsoft a également développé l’architecture du serveur lui-même. Chaque plateau de serveur contient quatre puces entièrement connectées avec des liens directs. Microsoft utilise l’Ethernet standard et son propre protocole de transport pour une communication rapide et fiable entre les puces. Redmond reste ainsi indépendant des interconnexions de tiers, comme Nvidia.

La puce est destinée aux charges de travail d’IA à grande échelle et sera initialement déployée dans les centres de données Azure de l’Iowa, puis plus tard en Arizona.

Efficacité de l’inférence LLM

Maia 200 doit accroître l’efficacité de l’exécution de grands modèles linguistiques, dont GPT-5.2 d’OpenAI. Les équipes internes telles que Microsoft Superintelligence utilisent également la puce, notamment pour la génération de données synthétiques et l’apprentissage par renforcement. Grâce à la structure de mémoire remaniée et au débit de données optimisé, Maia 200 est adapté à l’inférence à faible précision, ce qui devrait contribuer à la rentabilité.

Maia SDK

Pour les développeurs, un Maia SDK sera disponible, offrant entre autres une prise en charge de PyTorch, un compilateur Triton et des possibilités de programmation de bas niveau via NPL. Cela devrait aider à optimiser les modèles d’IA pour une utilisation sur le matériel Maia 200. Le Maia SDK est actuellement disponible en version préliminaire.

Grâce à un environnement de test pré-silicium, Microsoft a pu déployer le Maia 200 plus rapidement que les générations précédentes. Microsoft travaille déjà sur les futures générations de Maia.