Google introduit Ironwood. Il s’agit d’une puce développée en interne, construite autour de cœurs tensoriels d’IA et optimisée pour l’inférence dans le centre de données. Ironwood se positionne ainsi comme une alternative aux puces Nvidia.

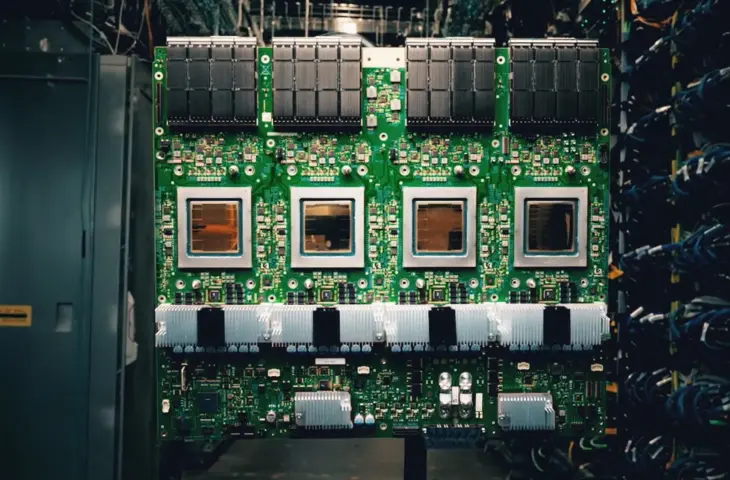

Lors de Google Cloud Next, Google présente la puce Ironwood. Ironwood représente la septième génération de l’Unité de Traitement Tensoriel (TPU) développée par Google en interne. Les TPU sont des puces dotées de cœurs tensoriels, optimisées pour les charges de travail d’IA.

Ironwood a été spécialement conçu dans l’optique de l’inférence. La puce est capable de charger et d’utiliser des modèles d’IA robustes. Chaque puce Ironwood dispose pour cela de 192 Go de mémoire à haute bande passante (HBM). C’est six fois plus que son prédécesseur Trillium. La bande passante HBM par puce a presque doublé, passant de 4,5 To/s pour Trillium à 7,2 To/s pour Ironwood.

Grappes

Google mettra les puces à disposition via des grappes dans le cloud. Celles-ci seront disponibles en deux tailles. Dans la version d’entrée de gamme, Google combine déjà 256 puces Ironwood, ce qui constitue de facto une grappe HPC capable de soutenir l’inférence à grande échelle.

Pour ceux qui désirent davantage, Google prévoit également des ‘pods’ de 9 216 puces Ironwood. Dans cette configuration, le système fournit, selon Google, 42,5 ExaFlops (FP8). Google affirme que le pod est plus rapide qu’El Capitan, mais cette affirmation est infondée : le superordinateur le plus rapide au monde est effectivement au moins deux fois plus performant. Nous supposons néanmoins qu’un cluster Ironwood comptant 9 216 puces est particulièrement puissant pour l’inférence d’IA à grande échelle.

Optimisation

Ironwood peut non seulement prendre en charge les LLM modernes, mais est également optimisé pour des charges de travail d’IA plus classiques. Pensez par exemple aux moteurs de recommandation : les systèmes capables de générer des offres personnalisées sur les boutiques en ligne. Le SparseCore intégré est un accélérateur spécialement conçu pour de telles tâches.

Google souligne également l’efficacité d’Ironwood. La puce fournit 29,3 Flops par Watt, alors que Trillium n’en fournissait que 14,6. Google ne révèle plus publiquement depuis un certain temps qui fabrique les TPU ou sur quel nœud. Compte tenu de l’efficacité, il s’agit probablement d’un nœud de processus actuel chez un fabricant important comme TSMC.

Puces propriétaires

Tous les grands acteurs du cloud travaillent sur leurs propres puces. Google a été rapide avec ses accélérateurs Tensor, mais AWS dispose également désormais d’un large portefeuille. Pensez aux CPU Graviton, aux puces d’entraînement Trainium et aux accélérateurs d’inférence Inferentia. Pour Microsoft, il s’agit de Maia.

Avec leurs propres puces (d’IA), les fournisseurs de cloud peuvent tenter de faire une différence plus nette entre leur offre et celle de la concurrence. De plus, ils réduisent ainsi leur dépendance vis-à-vis des puces très coûteuses de Nvidia, qui de surcroît ne sont pas toujours facilement disponibles. Ironwood est ainsi un atout pour Google vis-à-vis de ses clients, ainsi qu’une assurance contre la domination de Nvidia.