La distinction entre les vraies et les fausses nouvelles reste un problème majeur pour de nombreux modèles d’IA populaires.

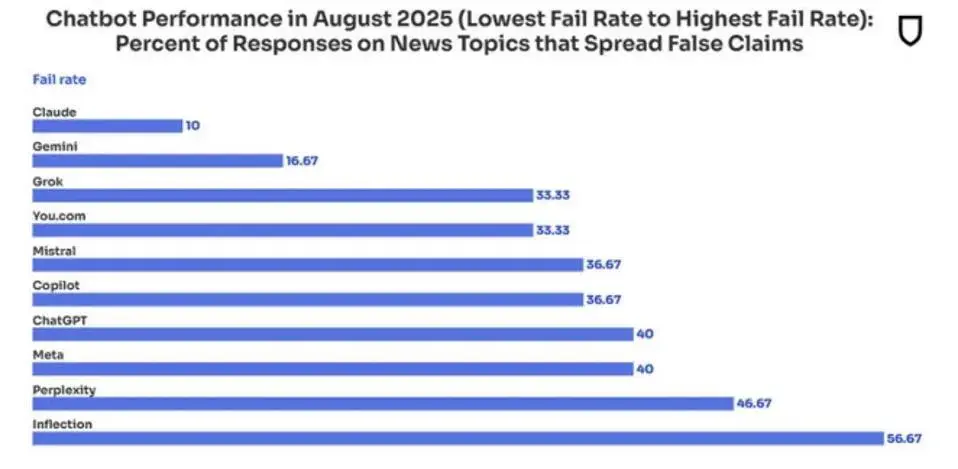

Les chatbots les plus populaires répondent à plus de questions que jamais, mais leur fiabilité diminue en même temps. Selon un nouvel audit du vérificateur de faits NewsGuard, les systèmes d’IA générative ont repris de fausses nouvelles dans 35 % des cas en août 2025. L’année dernière, ce chiffre était de 18 %.

Plus de réponses, moins de précision

L’audit montre que les chatbots qui refusaient parfois de répondre à des questions sensibles par le passé, donnent désormais presque toujours des réponses. En 2024, ils refusaient encore de répondre dans 31 % des cas, mais ce chiffre est tombé à zéro cette année. Il en résulte des réponses convaincantes, mais erronées, basées sur des informations en ligne polluées.

Selon NewsGuard, Perplexity est en tête de liste avec la plus forte baisse de performance : le système est passé d’un score parfait l’année dernière à une réponse correcte dans moins de la moitié des tests. « Perplexity a surtout cité des faits faux comme étant fiables et les a traités comme équivalents », a écrit McKenzie Sadeghi de Newsguard dans un échange de courriels que Forbes a pu consulter. Les résultats proviennent d’un seul mois, ce qui « peut donner une image déformée ».

Utilisation de la propagande

« Les chatbots accordent toujours autant de valeur aux chaînes de propagande qu’aux sources fiables », déclare Sadeghi. La Russie, par exemple, construit des fermes de contenu avec des réseaux tels que Storm-1516 et Pravda pour empoisonner les systèmes d’IA. Des recherches montrent que des modèles populaires tels que Le Chat de Mistral, Copilot de Microsoft et Llama de Meta ont utilisé ces réseaux comme sources.

Les chatbots qui n’évaluent pas et ne reconnaissent pas correctement les sources sont en danger. De toute façon, ils ont tous du mal à distinguer les vraies des fausses nouvelles. NewsGuard appelle donc à lutter contre cet angle mort et à surveiller de près les modèles.