Anthropic travaille actuellement sur un test pour faire fonctionner Claude directement dans le navigateur Chrome.

La société d’IA Anthropic a lancé un programme de test pour une extension Claude dans Google Chrome. L’agent d’IA effectuera ensuite des actions directement dans le navigateur. Cette nouvelle fonctionnalité sera provisoirement disponible pour 1 000 utilisateurs de l’abonnement Max, qui coûte environ 100 à 200 dollars par mois. Les personnes intéressées peuvent d’ores et déjà s’inscrire sur la liste d’attente. Le déploiement à plus grande échelle éventuel ne suivra qu’après la phase de test.

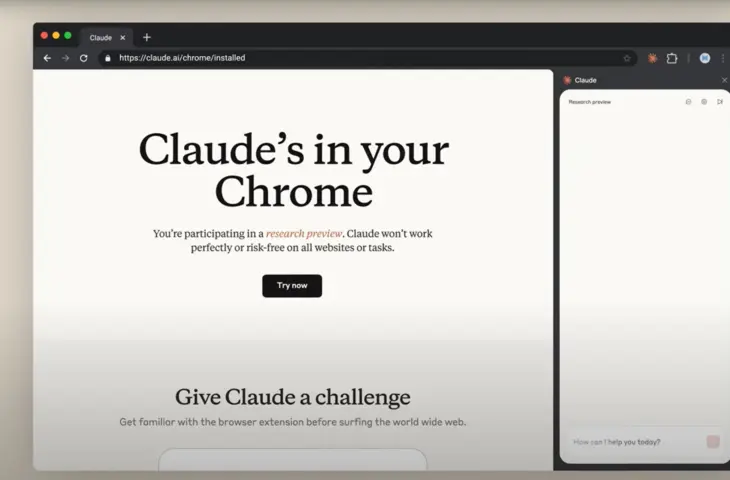

Claude dans Chrome

La nouvelle extension Chrome permet à Claude d’effectuer des tâches telles que cliquer, remplir des formulaires ou naviguer entre les pages. Les utilisateurs peuvent ensuite discuter avec Claude dans le navigateur via un panneau latéral qui apparaît à droite.

La fonctionnalité ne sera provisoirement disponible que pour 1 000 utilisateurs de l’abonnement Max. Ils peuvent s’inscrire via une liste d’attente. Anthropic souhaite, grâce à cette phase de test, obtenir un aperçu des applications pratiques, des points faibles et des risques de sécurité. Un déploiement plus large suivra ensuite.

L’IA est de plus en plus intégrée au navigateur. Ainsi, OpenAI travaillerait sur un navigateur web d’IA propre et Microsoft a récemment lancé un aperçu du mode Copilot Edge. L’essor des navigateurs basés sur l’IA est encore accéléré par la procédure antitrust en cours contre Google. Le juge pourrait en effet décider que Google doit vendre son navigateur Chrome, et les entreprises d’IA telles que Perplexity, qui ont déjà fait une offre, ne seraient que trop heureuses que cela se produise.

Nouveaux risques

Anthropic souligne en même temps dans son article de blog que les agents basés sur navigateur comportent également de nouveaux risques, tels que les attaques par injection d’invite. Dans ce cas, des personnes malveillantes tentent, via des instructions cachées, d’inciter les systèmes d’IA à adopter un comportement indésirable.

lire aussi

Claude a la possibilité d’interrompre les conversations en cas d’abus

Anthropic souligne que la période de test doit aider à découvrir les vecteurs d’attaque inconnus dans la pratique. Les commentaires issus de ce projet pilote sont utilisés pour affiner davantage les systèmes de sécurité, les paramètres d’autorisation et les modèles d’IA sous-jacents.