Avez-vous toute la RAM dont vous aurez besoin dans un avenir proche ? Ou au moins tous les nouveaux PC pour votre entreprise ont-ils déjà été achetés ? Si ce n’est pas le cas, espérons que vous n’en aurez pas besoin l’année prochaine, car l’IA fait grimper les prix en flèche.

L’IA améliorera le monde, si l’on en croit les agriculteurs de l’IA. Un peu de patience est peut-être de mise, mais nous devrons faire cet effort pour pouvoir bientôt entrer dans le jardin d’Eden piloté par l’IA, un ordinateur portable (IA) à la main. À court terme, le développement de l’IA et la construction de centres de données pour l’IA feront surtout en sorte que ce nouvel ordinateur coûte plus cher et que votre smartphone contienne moins de mémoire.

Triopole

Voici comment cela fonctionne : la mémoire est un marché très sensible à l’offre et à la demande. Cela s’explique par le fait qu’il n’y a que trois fabricants de mémoire importants : SK Hynix, Samsung Electronics et Micron. Ensemble, ils détiennent environ 93 % du marché.

Les puces de mémoire sont des microprocesseurs qui, comme les CPU et les GPU, sont gravés sur des wafers. SK Hynix, Samsung et Micron possèdent différentes usines contenant différentes lignes de production avec des équipements permettant de construire des puces de mémoire sur des wafers. La construction d’une telle usine prend des années et coûte des milliards, de sorte que les fabricants n’en ajoutent pas simplement une.

La RAM est le nouveau pétrole

Ils ont tiré les leçons : début 2023, le prix de la mémoire s’est effondré parce que la capacité des usines était beaucoup plus importante que l’offre. Vous voilà donc, en tant que fabricant de mémoire, avec une usine hors de prix où des puces sortent de la chaîne de production qui ne valent qu’une fraction de leur valeur de vente lorsque vous avez injecté des milliards dans l’usine. En réduisant quelque peu la production, le prix est remonté à un niveau viable, mais l’impact sur le bilan des fabricants était visible.

Vous voilà donc, en tant que fabricant de mémoire, avec une usine hors de prix où des puces sortent de la chaîne de production qui ne valent qu’une fraction de leur valeur de vente antérieure.

À cet égard, la mémoire est un peu comme le pétrole : une poignée d’acteurs décide de la capacité disponible, et ces acteurs n’ont aucun intérêt à ce qu’il y ait une offre excédentaire qui fasse baisser les prix. Une pénurie de mémoire ne leur est même pas défavorable : lorsque les prix augmentent, chaque usine génère plus de bénéfices.

L’IA a faim

Entre-temps, la demande augmente de façon spectaculaire, mais pas parce que nous voulons tous plus de DRAM dans nos ordinateurs portables. Les coupables sont les entreprises d’IA. Que vous souhaitiez entraîner des modèles d’IA ou effectuer une inférence, d’immenses quantités de mémoire sont essentielles. Pour l’inférence avec DeepSeek R1-70B, vous avez besoin d’environ 50 Go de mémoire, rien que pour charger le modèle. Pour les modèles plus importants comme GPT 5.2, c’est beaucoup plus.

La capacité de la mémoire est un facteur, la vitesse de la mémoire en est un autre. Pour exécuter facilement les charges de travail de l’IA, les fabricants tels que Nvidia connectent leurs accélérateurs d’IA à la High Bandwith Memory (HBM). Il s’agit d’une version de la mémoire empilée en 3D avec une bande passante plus élevée que la DRAM classique que l’on trouve dans les ordinateurs portables.

Des pétaoctets de demande de HBM

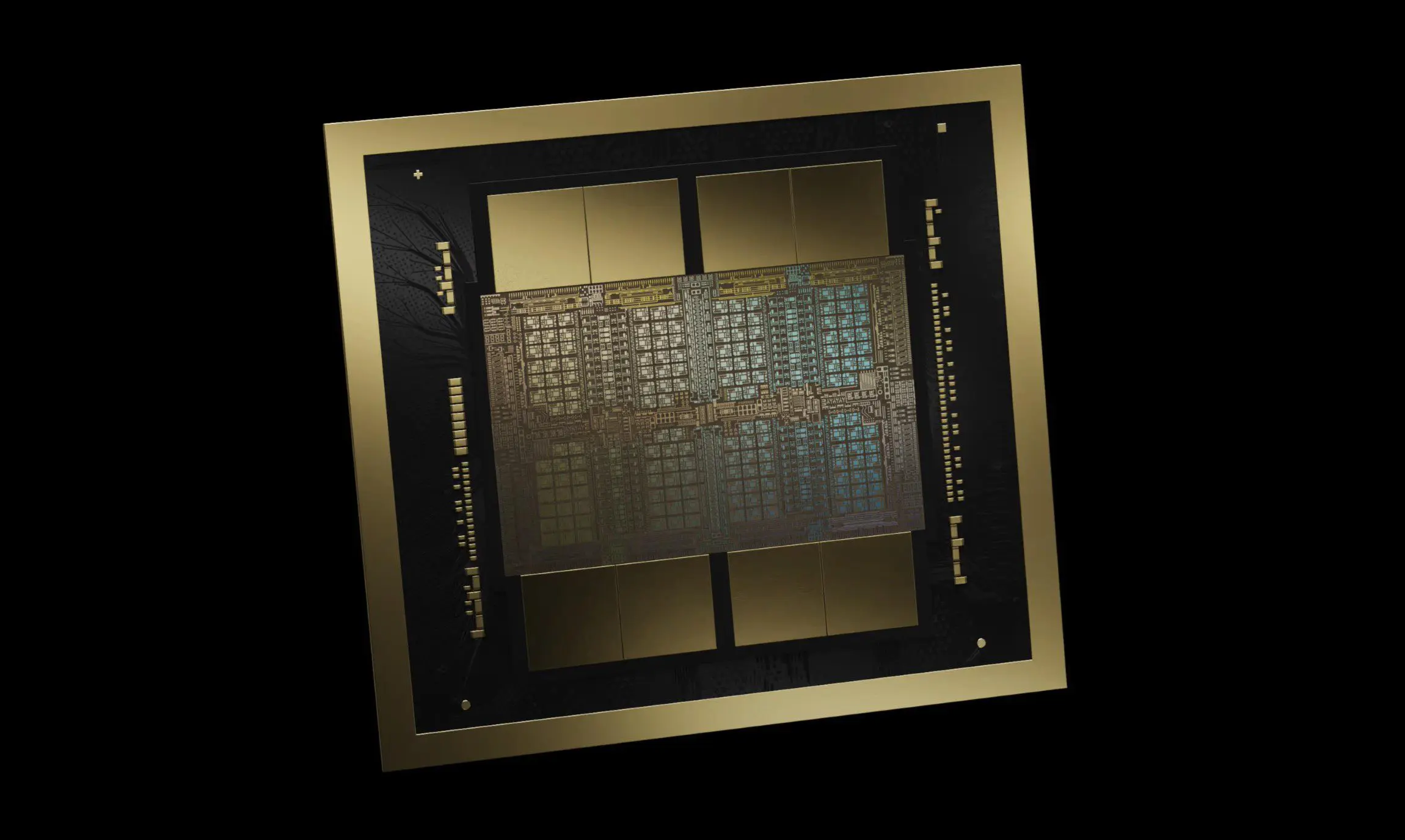

Le Nvidia Blackwell B200 est actuellement l’accélérateur d’IA le plus avancé. Microsoft, AWS, Google et Meta ont tous commandé pour environ dix milliards de dollars de puces à Nvidia. Microsoft voulait à lui seul entasser 50 000 puces Blackwell dans un seul centre de données. Un Nvidia Blackwell B200 possède 192 Go de HBM3e avancé à bord.

Pour répondre à cette soif de puces, des pétaoctets de HBM sont nécessaires. Nvidia (et AMD et d’autres) conçoivent les puces, mais la fabrication est assurée par TSMC avec de la mémoire de Samsung, SK Hynix ou Micron, dans les usines disponibles.

Reconfiguration des usines

La HBM est plus complexe que la DRAM, mais elle est construite sur les mêmes lignes de production. Une ligne de production où sort de la DRAM ne peut pas fabriquer de HBM pour les puces d’IA. L’équipement utilisé est plus ou moins le même : les fabricants peuvent reconfigurer leurs lignes de production pour fabriquer de la HBM.

La HBM se vend à un prix plus élevé que la DRAM

C’est ce qu’ils font également : la HBM se vend à un prix plus élevé que la DRAM. Les producteurs de mémoire ont fait le calcul et ont constaté qu’il était préférable de faire construire de la HBM dans leurs usines plutôt que de la DRAM. Les lignes de production pour la mémoire DDR4 (plus ancienne et donc moins chère) ont été les premières à disparaître. La DRAM DDR4 est devenue plus chère que la DDR5 plus moderne.

Moins de mémoire par wafer

La conversion de la capacité DRAM en capacité HBM ne se fait pas un pour un. La production de HBM nécessite des étapes supplémentaires et consomme plus de capacité de wafer. Pour un wafer avec une certaine capacité de HBM, un fabricant peut produire trois fois plus de DRAM.

La conversion des lignes de production DDR4 n’a donc pas permis d’étancher la soif de HBM pour l’IA. La prochaine victime : la DDR5. Micron a même préféré donner le coup de grâce à sa marque de RAM forte, Crucial, afin de pouvoir pivoter vers la HBM. C’est ennuyeux, car la DDR5-DRAM (et les variantes telles que la LPDDR5x) est la mémoire que l’on trouve dans les PC, les serveurs et les smartphones.

lire aussi

Micron dit adieu à sa propre marque de RAM Crucial dans sa quête d’argent lié à l’IA

Samsung, SK Hynix et Micron s’en moquent : la HBM rapporte plus que la DDR5, c’est donc la priorité. Cela crée bien sûr une nouvelle pénurie, à savoir pour la DDR5. Les fabricants de PC et de serveurs l’ont également constaté, de sorte qu’un stock a été constitué, ce qui a fait augmenter la demande.

Exponentiellement plus cher

Il n’est pas nécessaire d’avoir un master en économie pour deviner la suite : la demande augmente, l’offre diminue, donc le prix monte en flèche. C’est la situation dans laquelle nous nous trouvons actuellement. Un ensemble de mémoire RAM de 32 Go qui coûtait encore environ 80 euros en août 2025 se vend maintenant près de 350 euros.

Les fabricants de serveurs et d’ordinateurs ne peuvent pas échapper aux augmentations de prix. Pour eux aussi, le prix de la mémoire monte en flèche. Dans le segment d’entrée de gamme et de milieu de gamme des ordinateurs portables, les marges bénéficiaires ne sont pas vraiment énormes. Les fabricants ont constitué un stock modeste, mais ils sont en train de l’épuiser. L’augmentation des prix causée par la soif d’IA est donc répercutée.

Chronique d’une augmentation de prix annoncée

Ce n’est pas hypothétique. Tous les fabricants d’ordinateurs, de HP à Lenovo et Dell, ont entre-temps indiqué que de telles augmentations de prix sont à venir. Du smartphone à l’ordinateur portable et de bureau en passant par le serveur : le prix d’une configuration avec une quantité donnée de DRAM augmentera à partir du début de l’année 2026. Afin de continuer à proposer des appareils à certains prix intéressants, les fabricants réduiront également les configurations et mettront sur le marché des appareils avec moins de RAM.

lire aussi

Dell prend les devants avec les augmentations de prix des PC, Lenovo suit

Le timing est particulièrement douloureux étant donné la fin du support de Windows 10 par Microsoft. De nombreuses organisations ont souscrit à un support étendu pour continuer à travailler sur les PC existants. En reportant le renouvellement des ordinateurs portables de 2025 à 2026, le prix a augmenté.

SSD

L’augmentation des prix de la DRAM n’est que le début. Tous ces tout nouveaux superclusters d’IA avec leurs téraoctets de mémoire HBM veulent naturellement des données à charger dans cette mémoire. Ces données doivent provenir d’un stockage rapide, et c’est là que les SSD sont nécessaires.

Un système Vera Rubin de Nvidia est idéalement flanqué d’environ 1 125 To de SSD NAND. En 2026, environ 30 000 systèmes Vera Rubin seront livrés. En 2027, Nvidia en livrera 100 000 de plus. Un petit calcul nous apprend que les fabricants de SSD-NAND devront produire environ 150 millions de To de NAND au cours des deux prochaines années, rien que pour Vera Rubin. En 2027, Vera Rubin sera responsable de 9,3 % de la demande totale de SSD NAND.

lire aussi

L’IA rend désormais les SSD aussi sensiblement plus chers que la RAM

Vous pouvez deviner vous-même les conséquences. La NAND est en grande partie construite par les mêmes fabricants que la RAM. Samsung et SK Hynix sont les principaux acteurs, avec Sandisk. Ces trois parties ont déjà indiqué qu’elles doubleraient le prix de la NAND en 2026. Le prix des SSD a déjà augmenté par anticipation. On ne sait pas où se situe le plafond.

Le prix élevé des SSD déclenche un effet de cascade. Ceux qui préfèrent les SSD, mais peuvent aussi se contenter de HDD, sont poussés vers les HDD classiques en raison du prix élevé. Une partie de la demande de SSD se retrouve donc de manière inattendue chez les HDD, et donc le prix de ces composants augmente également.

(Pas de) patience

La patience est une vertu, mais ceux qui attendent une normalisation du prix devront attendre longtemps. Micron lui-même pense que les prix actuels de la RAM, qui continuent d’augmenter, évoluent vers la nouvelle norme. Le fabricant ne prévoit aucune baisse dans un avenir prévisible, a-t-il déclaré lors d’une explication des chiffres trimestriels.

En ce qui concerne les ordinateurs portables et de bureau, le prix augmentera au cours de l’année 2026. Les fabricants d’ordinateurs, toujours en lutte pour des parts de marché, vendent encore des systèmes aux conditions de prix actuelles tant que cela est possible. Lorsqu’ils devront eux-mêmes intégrer de la RAM plus chère, ils répercuteront l’augmentation de prix. Il en va de même pour les SSD.

Début 2026, vous pourrez encore acheter des PC aux prix précédents, mais cela ne durera pas longtemps. Pour la RAM séparée dans les systèmes auto-construits, il est déjà trop tard. La situation ne fera qu’empirer dans les semaines et les mois à venir.

Cet article est initialement paru le 26 décembre sous le titre « Espérons que le Père Noël a apporté de la RAM ». Il a été mis à jour avec les informations les plus récentes.