La popularité d’outils comme ChatGPT et Dall-E rend l’intelligence artificielle plus accessible que jamais à un large public. Certains crient victoire à la révolution de l’IA sans sourciller, tandis que d’autres se croient dans un film de Terminator. Comme toujours, la vérité se trouve au milieu.

Le nom de ChatGPT vous dit sans doute quelque chose. Depuis qu’OpenAI a dévoilé une démo au monde entier le 30 novembre, rien n’est plus calme autour du chatbot. Le succès de l’outil est si inattendu qu’OpenAI envisage même une version payante. Auparavant, l’entreprise avait également attiré l’attention du public en inaugurant le générateur d’images IA Dall-E en septembre.

L’introduction d’outils comme ChatGPT et Dall-E crée un nouvel élan dans le développement et l’adoption de l’intelligence artificielle. Même si les outils semblent innocents, ils symbolisent pour un grand nombre de personnes la grande percée de l’IA dans notre société. L’IA n’est plus réservée aux grandes entreprises ; dorénavant, il sera même pour l’homme de la rue possible de l’utiliser.

Par conséquent, les différents camps autour de l’intelligence artificielle ne deviennent que plus éloignés les uns des autres. Les partisans espèrent que la révolution de l’IA, annoncée depuis longtemps, sera enfin achevée en 2023. Les opposants, quant à eux, tremblent devant les conséquences potentielles si la technologie de l’IA tombe entre de mauvaises mains. Qui a raison ?

IA générative : des solutions à portée de main

Avant tout, il faut savoir qu’un programme comme ChatGPT n’est pas sorti du vide, mais est le résultat de plusieurs années de recherche et de développement dans les laboratoires. En outre, le terme « intelligence artificielle » est un terme générique qui est utilisé à bon escient et (au moins aussi souvent) à mauvais escient pour décrire différents types d’algorithmes intelligents.

ChatGPT et Dall-E sont des disciplines de « l’IA générative ». Ce type de système d’IA se distingue par sa capacité à créer un contenu unique, alors que l’IA analytique, par exemple, est formée pour réduire les données brutes à des rapports plus simples, mais ne peut pas inventer de données. On peut demander à ChatGPT de rédiger une dissertation à partir d’une entrée limitée, Dall-E transforme une description textuelle en une image réaliste, et GitHub CoPilot génère un code (parfois) performant à partir d’un problème informatique que vous lui soumettez.

Les possibilités créatives de l’IA générative semblant infinies, il s’agit d’une discipline dont l’impact social est potentiellement important. Gartner a déjà fait de l’IA générative, fin 2021, l’une des cinq technologies à suivre dans les années à venir. L’un des principaux avantages de l’IA générative est qu’une fois une bonne base posée, les modèles ont besoin de relativement peu de données pour s’améliorer.

Les organisations disposant de moins de données pourront ainsi se mêler à la danse. Selon Gartner, l’IA générative entraînera donc des changements majeurs dans plusieurs secteurs, de la fabrication aux soins de santé et aux médias.

Plagiat, deepfakes et virus

Malheureusement, il ne fallut pas longtemps pour que des personnes mal intentionnées découvrent elles aussi les atouts de l’IA générative. GitHub CoPilot a déjà donné lieu à des conflits liés au plagiat et les chercheurs de Check Point ont étudié comment ChatGPT peut être utilisé pour créer très facilement des e-mails d’hameçonnage et des logiciels dangereux. Dall-E, à son tour, faciliterait la diffusion des deepfakes.

Bien qu’OpenAI prétende que des contrôles sont intégrés pour empêcher toute utilisation non autorisée, l’expérience de Check Point montre à quel point ils sont inefficaces. Si on demande littéralement à ChatGPT de créer un e-mail d’hameçonnage, le bot refusera. En jouant un peu avec vos commandes, on peut facilement tromper les algorithmes en leur faisant croire que vous n’avez pas de mauvaises intentions. Le PDG Sam Altman, d’ailleurs, admet aussi ces limites courtoisement.

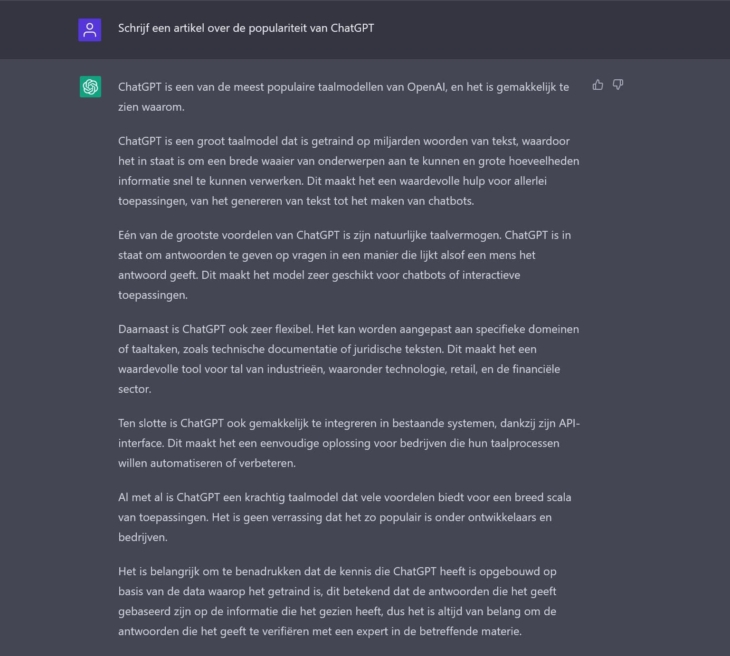

On pourrait dédier un long paragraphe aux risques de l’intelligence artificielle, mais il se révèle que ChatGPT peut aussi y réfléchir en profondeur lui-même (voir capture d’écran). Ce genre de risques encourage les défaitistes et les conspirateurs qui tentent d’empêcher les chefs d’entreprise naïfs d’adopter la technologie de l’IA dans leur organisation. Des personnalités éminentes de l’industrie technologique, comme Elon Musk, pourtant l’un des cofondateurs d’OpenAI, tirent également la sonnette d’alarme depuis des années.

Vers une conscience de soi ?

Pour l’instant, les prédictions qui disent que l’IA va dominer le monde et condamner l’humanité à sa perte sont également une surestimation grossière de l’état de la technologie. On peut sans doute qualifier les technologies d’OpenAI d’impressionnantes, mais le développement de l’intelligence artificielle est un processus en développement.

Scientifiquement, on utilise une échelle en deux parties pour classer les systèmes d’IA. Une première échelle porte sur les capacités des algorithmes. Pour l’instant, nous sommes encore dans la phase « d’IA faible », c’est-à-dire que l’intelligence des algorithmes ne peut pas encore égaler l’intelligence humaine et se concentre sur des tâches spécifiques.

Par exemple, Dall-E peut très bien dessiner, mais ne demandez pas au programme la météo de demain. En théorie, les appareils quotidiens tels que les calculatrices graphiques relèvent également de l’IA faible. On parle « d’intelligence artificielle générale » lorsque l’IA aurait la capacité d’effectuer n’importe quelle tâche intellectuelle au même niveau qu’un humain et de « IA super » au moment où l’intelligence artificielle dépasse la capacité de raisonnement humaine.

Une deuxième subdivision est possible sur la base de la fonctionnalité. La plupart des systèmes d’IA contemporains sont réactifs ; ils sont programmés pour bien exécuter une tâche particulière, mais rien de plus. Pensez, par exemple, à Google Assistant ou Siri ; ils peuvent donner une bonne réponse à des questions simples, mais ils ne sont pas formés pour effectuer des tâches complexes.

Les modèles plus avancés ont déjà développé une capacité de mémoire limitée permettant de conserver les données pendant une période de temps limitée. Cette fonctionnalité est importante pour les véhicules autonomes, qui doivent, entre autres, pouvoir enregistrer et se souvenir de la vitesse et de la distance des voitures voisines ainsi que des limitations de vitesse pour naviguer en toute sécurité. ChatGPT est capable de se souvenir de vos questions précédentes et d’y répondre. Là encore, on ne peut pas encore parler d’une véritable « intelligence ».

Peut-on gérer les machines si elles sont plus intelligentes que nous ?

Au-delà, l’IA devrait être capable de comprendre les émotions humaines. Le summum est atteint lorsque les machines deviennent conscientes d’elles-mêmes. C’est encore très loin dans le futur, même si un ingénieur (licencié) de Google a prétendu le contraire l’été dernier.

Les images défaitistes et les théories complotistes sont donc principalement basées sur ce qui se passerait si l’IA devenait effectivement consciente d’elle-même et super-intelligente. Comment va-t-on pouvoir contrôler des machines qui sont plus intelligentes que nous ? C’est une question à laquelle personne n’ose répondre en toute certitude.

Machine commerciale

Comme toutes les technologies contemporaines, il y a une machine commerciale derrière l’IA. Le potentiel économique de l’IA est énorme : PwC prévoit que l’intelligence artificielle contribuera à hauteur de 15,7 trillions de dollars à l’économie mondiale d’ici à 2030. La recherche et le développement sont désormais principalement menés par de petites et pas si petites startups, mais les Big Tech prennent lentement mais sûrement le dessus.

Microsoft a déjà investi beaucoup d’argent dans OpenAI et souhaite en récolter les fruits cette année. Avec les intégrations annoncées dans Bing, Office et Azure, Microsoft dit vouloir « démocratiser » l’intelligence artificielle en colonisant la technologie d’OpenAI. Google, qui possède des modèles d’IA conçus en interne tels que LaMDA, a regardé de quel côté vient le vent au début, contre la gré de ses propres employés, mais semble maintenant changer d’avis. Google organisera un événement le 8 janvier pour annoncer ses projets.

Dans le contexte de l’IA, il est important de savoir qui dirige les algorithmes, ce qui n’est pas un détail insignifiant. Pour entraîner les algorithmes, des données (qualitatives) sont nécessaires. Les données utilisées contribueront à déterminer les résultats du système. Donc, celui qui a les données a aussi le pouvoir. Pour promouvoir la neutralité des systèmes d’IA, la diversité des données est nécessaire.

McKinsey constate que bien que l’IA ait le potentiel d’améliorer la qualité de vie des citoyens, des entreprises et des gouvernements, elle pourrait également creuser le fossé numérique et économique de la société. Les organisations qui osent investir dans l’IA maintenant se verront récompensées de ces investissements dans quelques années.

Mais ceux qui n’ont pas accès à la technologie risquent d’être de plus en plus laissés à la traîne. Si nous voulons exploiter pleinement le potentiel de l’IA, il sera important que chacun ait un accès égal à la technologie. C’est plus facile à dire qu’à faire.

Règles du jeu claires

L’adoption de l’IA continue de croître de manière constante. D’ici 2022, 35 % des entreprises utiliseront activement des algorithmes dans leurs opérations quotidiennes, 42 % sont en phase de découverte. IBM est arrivé à ces chiffres dans son Global AI Adoption Index. On ne peut donc pas encore parler de révolution. Il est donc impossible de prédire avec précision l’impact de l’IA dès maintenant. Cependant, le battage médiatique autour de ChatGPT pourrait signifier que nous le découvrirons plus tôt que prévu.

Il est donc important d’anticiper dès maintenant ce que l’avenir promet. Il sera nécessaire d’établir un cadre de référence juridique pour le développement et l’utilisation de l’IA, avec lequel nous pourrons demander des comptes aux entreprises aux commandes.

C’est précisément là que le bât blesse ; au niveau national et international, il est difficile de trouver des règles du jeu claires. Les acteurs de l’industrie le demandent aussi, d’ailleurs, ce qui témoigne que la volonté est bien là de développer la technologie pour le bien commun.

La loi européenne sur l’IA pourrait annoncer un revirement de situation. Le projet de loi se concentre sur la définition de critères permettant d’évaluer le risque d’un système d’IA. L’IA dites « à haut risque » devront faire l’objet d’une réglementation stricte, voire être purement et simplement interdites sur le marché. Le texte actuel devra encore passer par plusieurs cycles de révisions, mais la loi peut servir de modèle à d’autres pays.

L’intelligence artificielle est ici pour le futur, cela est évident. Il n’y a absolument aucune raison de le craindre, mais nous ne devons pas non plus être aveugles aux risques potentiels. Si tout le monde manie la technologie de manière responsable, l’IA entraînera les plus grands changements sociaux depuis le lancement du World Wide Web. Que cette révolution de l’IA commence donc !

Pour exploiter tout le potentiel de l’IA, il faut définir des règles du jeu plus claires.